Fusion thermonucléaire. Fusion froide : les expériences créent une énergie qui ne devrait pas exister

Lire aussi

La fusion thermonucléaire contrôlée est un processus physique intéressant qui (encore en théorie) peut sauver le monde de la dépendance énergétique aux sources de combustibles fossiles. Le processus est basé sur la synthèse de noyaux atomiques des plus légers aux plus lourds avec libération d'énergie. Contrairement à une autre utilisation de l’atome – la libération d’énergie dans les réacteurs nucléaires lors de sa désintégration – la fusion du papier ne laissera pratiquement aucun sous-produit radioactif. Des espoirs particuliers sont placés dans le réacteur ITER, dont la création a coûté des sommes folles. Les sceptiques s’appuient cependant sur les développements des entreprises privées.

En 2018, des scientifiques ont rapporté une triste nouvelle : malgré les inquiétudes concernant le réchauffement climatique, le charbon produisait 38 % de l'électricité mondiale en 2017, soit la même quantité qu'au début des alertes climatiques il y a 20 ans. Pire encore Les émissions de gaz à effet de serre ont augmenté de 2,7 % l'an dernier, soit la plus forte augmentation en sept ans. Cette stagnation a conduit même les politiciens et les environnementalistes à penser que nous avons besoin de plus d’énergie nucléaire.

- Traduction

Ce domaine est désormais appelé réactions nucléaires à basse énergie, et c'est peut-être là que de vrais résultats sont obtenus - ou il peut s'avérer être une science inutile et obstinée.

Le Dr Martin Fleischman (à droite), électrochimiste, et Stanley Pons, président du département de chimie de l'Université de l'Utah, répondent aux questions du Comité des sciences et technologies sur leurs travaux controversés sur la fusion froide, le 26 avril 1989.

Howard J. Wilk - chimiste, spécialiste des matières organiques synthétiques, déjà pendant longtemps ne travaille pas dans sa spécialité et vit à Philadelphie. Comme beaucoup d'autres chercheurs pharmaceutiques, il a été victime des coupes dans la R&D de l'industrie pharmaceutique ces dernières années et occupe désormais des emplois à temps partiel sans rapport avec la science. Avec du temps libre, Wilk suit les progrès de la société Brilliant Light Power (BLP) du New Jersey.

C'est l'une de ces entreprises qui développent des procédés que l'on peut généralement qualifier de nouvelles technologies d'extraction d'énergie. Le mouvement est en grande partie une résurrection de la fusion froide, un phénomène éphémère des années 1980 impliquant la production de fusion nucléaire dans un simple appareil électrolytique de paillasse que les scientifiques ont rapidement rejeté.

En 1991, le fondateur du BLP, Randall L. Mills, a annoncé lors d'une conférence de presse à Lancaster, en Pennsylvanie, le développement d'une théorie dans laquelle un électron dans l'hydrogène pourrait passer d'un état d'énergie fondamental normal à un état d'énergie auparavant inconnu, plus stable et plus faible. états. , avec la libération d’énormes quantités d’énergie. Mills a qualifié cela d'étrange nouveau genre hydrogène comprimé, " ", et travaille depuis au développement d'un appareil commercial qui récupère cette énergie.

Wilk a étudié la théorie de Mills, lu des articles et des brevets et effectué ses propres calculs pour les hydrinos. Wilk a même assisté à une démonstration sur le terrain du BLP à Cranbury, dans le New Jersey, où il a discuté de l'hydrino avec Mills. Après cela, Wilk n'arrive toujours pas à décider si Mills est un génie irréaliste, un scientifique délirant ou quelque chose entre les deux.

L'histoire commence en 1989, lorsque les électrochimistes Martin Fleischmann et Stanley Pons ont fait l'annonce étonnante lors d'une conférence de presse de l'Université de l'Utah qu'ils avaient apprivoisé l'énergie de fusion nucléaire dans une cellule électrolytique.

Lorsque les chercheurs ont appliqué un courant électrique à la cellule, ils ont cru que les atomes de deutérium eau lourde, qui a pénétré dans la cathode de palladium, est entré dans une réaction de fusion et a généré des atomes d'hélium. L’énergie excédentaire du processus était convertie en chaleur. Fleischmann et Pons ont fait valoir que ce processus ne pouvait être le résultat d'une réaction chimique connue et ont ajouté le terme " fusion froide».

Cependant, après plusieurs mois d'enquête sur leurs mystérieuses observations, la communauté scientifique a convenu que l'effet était instable, voire inexistant, et que des erreurs avaient été commises dans l'expérience. La recherche a été abandonnée et la fusion froide est devenue synonyme de science indésirable.

La fusion froide et la production d’hydrino sont le Saint Graal pour produire une énergie infinie, bon marché et propre. La fusion froide a déçu les scientifiques. Ils voulaient croire en lui, mais leur esprit collectif a décidé que c'était une erreur. Une partie du problème résidait dans l'absence d'une théorie généralement acceptée pour expliquer le phénomène proposé - comme le disent les physiciens, on ne peut pas faire confiance à une expérience tant qu'elle n'est pas confirmée par une théorie.

Mills a sa propre théorie, mais de nombreux scientifiques n'y croient pas et considèrent les hydrinos comme improbables. La communauté a rejeté la fusion froide et a ignoré Mills et son travail. Mills fit de même, essayant de ne pas tomber dans l'ombre de la fusion froide.

Entre-temps, le domaine de la fusion froide a changé son nom pour devenir des réactions nucléaires à basse énergie (LENR) et continue d'exister. Certains scientifiques continuent de tenter d'expliquer l'effet Fleischmann-Pons. D’autres ont rejeté la fusion nucléaire mais explorent d’autres processus possibles qui pourraient expliquer l’excès de chaleur. Comme Mills, ils étaient attirés par le potentiel d’applications commerciales. Ils s'intéressent principalement à la production d'énergie pour les besoins industriels, les ménages et les transports.

Le petit nombre d'entreprises créées pour tenter de commercialiser de nouvelles technologies énergétiques ont des modèles économiques similaires à ceux de n'importe quelle startup technologique : identifier une nouvelle technologie, essayer de breveter l'idée, susciter l'intérêt des investisseurs, obtenir des financements, construire des prototypes, réaliser des démonstrations, annoncer dates de vente des appareils pour travailleurs. Mais dans le nouveau monde énergétique, le non-respect des délais est la norme. Personne n'a encore franchi la dernière étape consistant à démontrer un appareil fonctionnel.

Nouvelle théorie

Mills a grandi dans une ferme en Pennsylvanie, a obtenu un diplôme en chimie du Franklin and Marshall College, un diplôme en médecine de l'Université Harvard et a étudié le génie électrique au Massachusetts Institute of Technology. En tant qu'étudiant, il a commencé à développer une théorie qu'il a appelée la « Théorie grande unifiée de la physique classique », qui, selon lui, était basée sur la physique classique et proposait un nouveau modèle d'atomes et de molécules qui s'éloignait des fondements de la physique quantique.Il est généralement admis qu’un seul électron d’hydrogène s’élance autour de son noyau, situé sur l’orbite la plus appropriée de l’état fondamental. Il est tout simplement impossible de rapprocher un électron d’hydrogène du noyau. Mais Mills dit que c'est possible.

Aujourd'hui chercheur chez Airbus Defence & Space, il affirme ne pas avoir surveillé les activités de Mills depuis 2007 car les expériences n'ont pas montré de signes clairs d'excès d'énergie. "Je doute qu'aucune des expériences ultérieures ait été scientifiquement sélectionnée", a déclaré Rathke.

« Je pense qu'il est généralement admis que la théorie du Dr Mills, qui sert de base à ses affirmations, est controversée et non prédictive », poursuit Rathke. – On pourrait se demander : « Pourrions-nous si heureusement tomber sur une source d’énergie qui fonctionne simplement en suivant les mauvaises approche théorique?" ».

Dans les années 1990, plusieurs chercheurs, dont une équipe de Centre de recherche Lewis, a rapporté de manière indépendante avoir reproduit l'approche de Mills et généré un excès de chaleur. L'équipe de la NASA a écrit dans le rapport que "les résultats sont loin d'être convaincants" et n'a rien dit sur l'hydrino.

Les chercheurs ont proposé des processus électrochimiques possibles pour expliquer la chaleur, notamment des irrégularités dans la cellule électrochimique, des réactions chimiques exothermiques inconnues et la recombinaison d'atomes d'hydrogène et d'oxygène séparés dans l'eau. Les mêmes arguments ont été avancés par les critiques des expériences Fleischmann-Pons. Mais l'équipe de la NASA a précisé que les chercheurs ne devraient pas ignorer le phénomène, juste au cas où Mills aurait quelque chose à dire.

Mills parle très vite et peut continuer encore et encore détails techniques. En plus de prédire les hydrinos, Mills affirme que sa théorie peut parfaitement prédire l'emplacement de n'importe quel électron dans une molécule à l'aide d'un logiciel de modélisation moléculaire spécial, et même dans des molécules complexes telles que l'ADN. Utilisation de la norme théorie des quanta Les scientifiques ont du mal à prédire le comportement exact de quelque chose de plus complexe qu’un atome d’hydrogène. Mills affirme également que sa théorie explique le phénomène d'expansion de l'Univers avec accélération, que les cosmologistes n'ont pas encore complètement compris.

De plus, Mills affirme que les hydrinos sont créés par la combustion d'hydrogène dans des étoiles telles que notre Soleil et qu'ils peuvent être détectés dans le spectre de la lumière des étoiles. L'hydrogène est considéré comme l'élément le plus abondant dans l'univers, mais Mills soutient que l'hydrino est de la matière noire, introuvable dans l'univers. Les astrophysiciens sont surpris par de telles suggestions : « Je n'ai jamais entendu parler des hydrinos », déclare Edward W. (Rocky) Kolb de l'Université de Chicago, expert de l'univers sombre.

Mills a rapporté l'isolement et la caractérisation réussis des hydrinos à l'aide de techniques spectroscopiques standard telles que la spectroscopie infrarouge, Raman et par résonance magnétique nucléaire. De plus, a-t-il ajouté, les hydrinos peuvent entrer dans des réactions qui conduisent à l’émergence de nouveaux types de matériaux avec « propriétés étonnantes" Cela inclut les conducteurs qui, selon Mills, révolutionneront le monde des appareils électroniques et des batteries.

Et bien que ses déclarations contredisent l'opinion publique, les idées de Mills ne semblent pas si exotiques par rapport à d'autres composants inhabituels de l'Univers. Par exemple, le muonium est une entité exotique connue à courte durée de vie composée d’un antimuon (une particule chargée positivement semblable à un électron) et d’un électron. Chimiquement, le muonium se comporte comme un isotope de l’hydrogène, mais il est neuf fois plus léger.

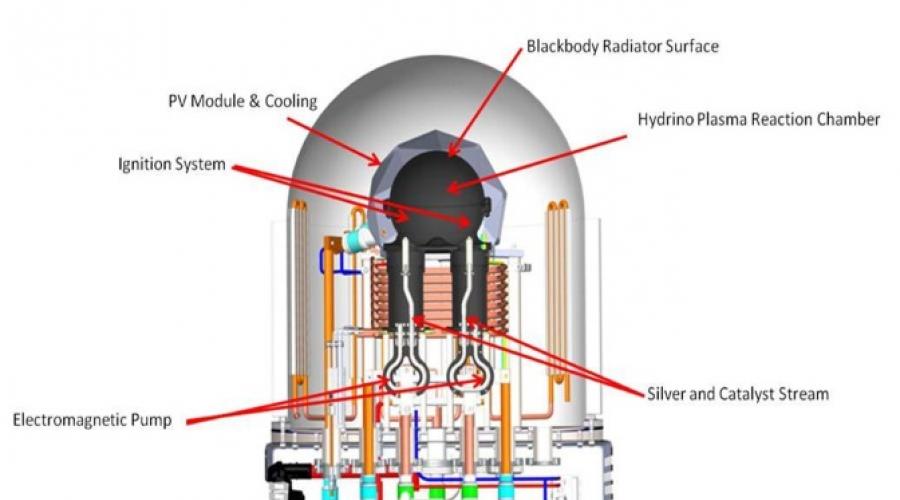

SunCell, pile à combustible à hydrine

Quelle que soit la position des hydrinos sur l'échelle de crédibilité, Mills a déclaré il y a dix ans que BLP avait dépassé la confirmation scientifique et ne s'intéressait qu'à l'aspect commercial des choses. Au fil des ans, BLP a levé plus de 110 millions de dollars en investissements.L'approche de BLP en matière de création d'hydrinos s'est manifestée de diverses manières. Dans les premiers prototypes, Mills et son équipe utilisaient des électrodes de tungstène ou de nickel avec une solution électrolytique de lithium ou de potassium. Le courant fourni divise l'eau en hydrogène et oxygène, et quand les bonnes conditions le lithium ou le potassium jouaient le rôle de catalyseur pour absorber l’énergie et effondrer l’orbite électronique de l’hydrogène. L'énergie créée par la transition de l'état atomique fondamental à un état d'énergie inférieure a été libérée sous la forme d'un plasma brillant à haute température. La chaleur associée était ensuite utilisée pour créer de la vapeur et alimenter un générateur électrique.

BLP teste actuellement un dispositif appelé SunCell, qui alimente en hydrogène (à partir de l'eau) et un catalyseur d'oxyde dans un réacteur à charbon sphérique avec deux flux d'argent fondu. Un courant électrique appliqué à l’argent déclenche une réaction plasmatique pour former des hydrinos. L'énergie du réacteur est captée par le carbone, qui agit comme un « radiateur à corps noir ». Lorsqu’il atteint des milliers de degrés, il émet de l’énergie sous forme de lumière visible, qui est captée par des cellules photovoltaïques qui convertissent la lumière en électricité.

Concernant développements commerciaux Mills apparaît parfois comme paranoïaque et à d’autres moments comme un homme d’affaires pratique. Il s'est inscrit marque déposée"Hydrino". Et parce que ses brevets revendiquent l'invention de l'hydrino, BLP revendique la propriété intellectuelle de la recherche sur l'hydrino. Pour cette raison, le BLP interdit à d’autres expérimentateurs de mener même des recherches fondamentales sur les hydrinos qui pourraient confirmer ou réfuter leur existence sans signer au préalable un accord de propriété intellectuelle. "Nous invitons les chercheurs, nous voulons que d'autres le fassent", explique Mills. "Mais nous devons protéger notre technologie."

Au lieu de cela, Mills a nommé des validateurs autorisés qui prétendent être en mesure de confirmer la fonctionnalité des inventions BLP. L'un d'eux est le professeur Peter M. Jansson, ingénieur électricien à l'Université de Bucknell, qui est payé pour évaluer la technologie BLP par l'intermédiaire de sa société de conseil, Integrated Systems. Jenson déclare que la rémunération de son temps « n’affecte en rien mes conclusions car chercheur indépendant découvertes scientifiques" Il ajoute qu'il a « réfuté la plupart des conclusions » qu'il a étudiées.

"Les scientifiques du BLP font de la vraie science et jusqu'à présent, je n'ai trouvé aucune erreur dans leurs méthodes et approches", déclare Jenson. – Au fil des années, j’ai vu de nombreux appareils en BLP qui sont clairement capables de produire un excès d’énergie en quantités significatives. Je pense qu’il faudra un certain temps à la communauté scientifique pour accepter et digérer la possibilité de l’existence d’états de faible énergie de l’hydrogène. À mon avis, le travail du Dr Mills est indéniable. » Jenson ajoute que BLP est confronté à des défis dans la commercialisation de la technologie, mais que les obstacles sont de nature commerciale et non scientifique.

Entre-temps, BLP a organisé plusieurs démonstrations de ses nouveaux prototypes auprès des investisseurs depuis 2014 et a publié des vidéos sur son site Internet. Mais ces événements ne prouvent pas clairement que SunCell fonctionne réellement.

En juillet, à la suite d'une de ses démonstrations, la société a annoncé que le coût estimé de l'énergie produite par SunCell était si bas – 1 à 10 % de toute autre forme d'énergie connue – que la société « allait fournir des produits autonomes et personnalisés ». alimentations pour pratiquement tous les appareils fixes et Applications mobiles, non lié au réseau électrique ou aux sources d'énergie combustibles. En d’autres termes, l’entreprise prévoit de construire et de louer des SunCells ou d’autres appareils aux consommateurs, en facturant des frais journaliers, leur permettant de se déconnecter du réseau et d’arrêter d’acheter de l’essence ou de l’énergie solaire tout en dépensant une fraction de l’argent.

"C'est la fin de l'ère du feu, du moteur combustion interne Et systèmes centralisés approvisionnement en énergie », déclare Mills. « Notre technologie rendra obsolètes toutes les autres formes de technologie énergétique. Les problèmes du changement climatique seront résolus. » Il ajoute qu'il semble que BLP pourrait commencer la production, pour commencer avec des centrales MW, d'ici la fin de 2017.

Qu'est-ce qu'il y a dans un nom?

Malgré l’incertitude entourant Mills et le BLP, leur histoire n’est qu’une partie de la plus grande saga des nouvelles énergies. Alors que la poussière retombait après l'annonce initiale de Fleischmann-Pons, deux chercheurs ont commencé à étudier ce qui était bien et ce qui n'allait pas. Ils ont été rejoints par des dizaines de co-auteurs et de chercheurs indépendants.Beaucoup de ces scientifiques et ingénieurs, souvent autofinancés, étaient moins intéressés par les opportunités commerciales que par la science : électrochimie, métallurgie, calorimétrie, spectrométrie de masse et diagnostic nucléaire. Ils ont continué à mener des expériences produisant un excès de chaleur, défini comme la quantité d'énergie produite par un système par rapport à l'énergie nécessaire à son fonctionnement. Dans certains cas, des anomalies nucléaires ont été signalées, comme l'apparition de neutrinos, de particules alpha (noyaux d'hélium), d'isotopes d'atomes et de transmutations de certains éléments en d'autres.

Mais en fin de compte, la plupart des chercheurs cherchent une explication à ce qui se passe et seraient heureux si même une modeste quantité de chaleur était utile.

"Les LENR sont en phase expérimentale et ne sont pas encore compris théoriquement", explique David J. Nagel, professeur de génie électrique et d'informatique à l'université. George Washington et ancien directeur sur la recherche au Laboratoire de Recherche Marine. « Certains résultats sont tout simplement inexplicables. Appelez cela fusion froide, réactions nucléaires à faible énergie ou autre – il y a plein de noms – nous n’en savons toujours rien. Mais il ne fait aucun doute que des réactions nucléaires peuvent être déclenchées en utilisant de l’énergie chimique. »

Nagel préfère appeler le phénomène LENR « réactions nucléaires en réseau », car le phénomène se produit dans les réseaux cristallins de l'électrode. Une première émanation de ce domaine se concentre sur l’introduction de deutérium dans une électrode de palladium en appliquant une énergie élevée, explique Nagel. Les chercheurs ont rapporté que de tels systèmes électrochimiques peuvent produire jusqu’à 25 fois plus d’énergie qu’ils n’en consomment.

L’autre rejeton majeur de ce domaine utilise des combinaisons de nickel et d’hydrogène, qui produisent jusqu’à 400 fois plus d’énergie qu’elles n’en consomment. Nagel aime comparer ces technologies LENR au réacteur expérimental international à fusion, basé sur la physique bien connue - la fusion du deutérium et du tritium - qui est en construction dans le sud de la France. Le projet, d'une durée de 20 ans, coûte 20 milliards de dollars et vise à produire 10 fois l'énergie consommée.

Nagel affirme que le domaine du LENR se développe partout et que les principaux obstacles sont le manque de financement et des résultats incohérents. Par exemple, certains chercheurs rapportent qu’il faut atteindre un certain seuil pour déclencher la réaction. Elle peut exiger quantité minimum le deutérium ou l'hydrogène pour se déclencher, ou les électrodes doivent être préparées avec une orientation cristallographique et une morphologie de surface. Cette dernière exigence est courante pour les catalyseurs hétérogènes utilisés dans la purification de l’essence et la production pétrochimique.

Nagel reconnaît que le côté commercial de LENR a également des problèmes. Les prototypes en cours de développement sont, dit-il, « assez rudimentaires » et aucune entreprise n’a encore fait la démonstration d’un prototype fonctionnel ou n’en a tiré profit.

E-Cat de Russie

L'une des tentatives les plus frappantes visant à commercialiser LENR a été réalisée par un ingénieur de Leonardo Corp, situé à Miami. En 2011, Rossi et ses collègues ont annoncé lors d'une conférence de presse en Italie la construction d'un réacteur de table « Energy Catalyst », ou E-Cat, qui produit un excès d'énergie dans un processus utilisant le nickel comme catalyseur. Pour justifier l'invention, Rossi a présenté l'E-Cat à des investisseurs potentiels et aux médias et a commandé des tests indépendants.

Rossi affirme que son E-Cat subit un processus auto-entretenu dans lequel un courant électrique entrant déclenche la synthèse d'hydrogène et de lithium en présence d'un mélange de poudre de nickel, de lithium et d'hydrure de lithium et d'aluminium, ce qui donne un isotope de béryllium. Le béryllium de courte durée se désintègre en deux particules alpha et l'excès d'énergie est libéré sous forme de chaleur. Une partie du nickel se transforme en cuivre. Rossi parle de l'absence de déchets et de radiations à l'extérieur de l'appareil.

L'annonce de Rossi a donné aux scientifiques la même sensation désagréable que la fusion froide. De nombreuses personnes se méfient de Rossi en raison de son passé controversé. En Italie, il a été accusé de fraude en raison de ses relations commerciales antérieures. Rossi dit que les allégations appartiennent au passé et ne veut pas en discuter. Il a également eu un contrat pour créer des systèmes thermiques pour l'armée américaine, mais les appareils qu'il a fournis ne fonctionnaient pas selon les spécifications.

En 2012, Rossi a annoncé la création d'un système de 1 MW adapté au chauffage de grands bâtiments. Il a également supposé qu'en 2013, il disposerait déjà d'une usine produisant chaque année un million d'unités de 10 kW de la taille d'un ordinateur portable, conçues pour Utilisation à la maison. Mais ni l'usine ni ces appareils n'ont jamais vu le jour.

En 2014, Rossi a concédé la technologie sous licence à Industrial Heat, la société d'investissement publique de Cherokee qui achète des biens immobiliers et libère d'anciens sites industriels pour de nouveaux développements. En 2015 PDG Cherokee, Tom Darden, avocat et spécialiste de l'environnement de formation, a qualifié la chaleur industrielle de « source de financement pour les inventeurs du LENR ».

Darden affirme que Cherokee a lancé Industrial Heat parce que la société d'investissement estime que la technologie LENR mérite d'être étudiée. « Nous étions prêts à nous tromper, nous étions prêts à investir du temps et des ressources pour voir si cette zone pouvait être utile dans notre mission de prévention de la pollution. environnement]," il dit.

Pendant ce temps, Industrial Heat et Leonardo se sont disputés et se poursuivent désormais en justice pour violation de l'accord. Rossi recevrait 100 millions de dollars si un test d'un an de son système de 1 MW réussissait. Rossi affirme que le test est terminé, mais Industrial Heat ne le pense pas et craint que l'appareil ne fonctionne pas.

Nagel dit qu'E-Cat a apporté de l'enthousiasme et de l'espoir dans le domaine du NLNR. Il a affirmé en 2012 qu'il pensait que Rossi n'était pas un fraudeur, "mais je n'aime pas certaines de ses approches en matière de tests". Nagel pensait que Rossi aurait dû agir avec plus de prudence et de transparence. Mais à cette époque, Nagel lui-même pensait que des appareils basés sur le principe LENR seraient mis en vente d'ici 2013.

Rossi poursuit ses recherches et a annoncé le développement d'autres prototypes. Mais il ne parle pas beaucoup de son travail. Il affirme que des unités de 1 MW sont déjà en production et qu'il a reçu les « certifications nécessaires » pour les vendre. Les appareils domestiques, a-t-il déclaré, attendent toujours leur certification.

Nagel dit qu'après que l'exaltation entourant les annonces de Rossi se soit calmée, le statu quo est revenu au NLNR. La disponibilité des générateurs commerciaux LENR a été retardée de plusieurs années. Et même si l'appareil survit aux problèmes de reproductibilité et s'avère utile, ses développeurs sont confrontés à une bataille difficile avec les régulateurs et l'acceptation des utilisateurs.

Mais il reste optimiste. «Le LENR pourrait devenir disponible dans le commerce avant d'être pleinement compris, tout comme les rayons X l'étaient», dit-il. Il a déjà équipé un laboratoire à l'Université. George Washington pour de nouvelles expériences avec le nickel et l'hydrogène.

Patrimoine scientifique

De nombreux chercheurs qui continuent de travailler sur LENR sont déjà des scientifiques retraités accomplis. Ce n’est pas facile pour eux, car pendant des années leurs travaux ont été renvoyés sans examen par les revues grand public, et leurs propositions de présentation à des conférences scientifiques ont été rejetées. Ils s’inquiètent de plus en plus du statut de ce domaine de recherche à mesure que leur temps presse. Soit ils veulent enregistrer leur héritage dans histoire scientifique NEYAR, ou du moins rassurez-vous en sachant que leur instinct ne les a pas laissé tomber."C'était très malheureux lorsque la fusion froide a été publiée pour la première fois en 1989 sous le titre nouvelle source l'énergie de fusion, pas seulement une nouvelle curiosité scientifique », déclare l'électrochimiste Melvin Miles. "Peut-être que la recherche pourrait se dérouler comme d'habitude, avec une étude plus minutieuse et plus précise."

Ancien chercheur au China Lake Air and Maritime Research Center, Miles a parfois travaillé avec Fleischman, décédé en 2012. Miles pense que Fleischman et Pons avaient raison. Mais à ce jour, il ne sait pas comment fabriquer une source d’énergie commerciale pour un système palladium-deutérium, malgré de nombreuses expériences qui ont produit un excès de chaleur en corrélation avec la production d’hélium.

« Pourquoi quelqu’un continuerait-il à faire des recherches ou à s’intéresser à un sujet qui a été déclaré erroné il y a 27 ans ? – demande Miles. – Je suis convaincu que la fusion froide sera un jour reconnue comme une autre découverte importante, ce qui est accepté depuis longtemps, et une plate-forme théorique apparaîtra pour expliquer les résultats des expériences.

Physicien nucléaire Ludwik Kowalski, professeur émérite de Montclair Université d'État reconnaît que la fusion froide a été victime d'un mauvais départ. "Je suis assez vieux pour me souvenir de l'effet que la première annonce a eu sur la communauté scientifique et le public", déclare Kowalski. Il a parfois collaboré avec les chercheurs du NLNR, « mais mes trois tentatives pour confirmer ces affirmations sensationnelles ont échoué ».

Kowalski estime que la honte initiale suscitée par la recherche a abouti à plus gros problème inadapté à la méthode scientifique. Que les chercheurs du LENR soient justes ou non, Kowalski estime toujours qu'il vaut la peine d'aller au fond d'un verdict clair par oui ou par non. Mais on ne le trouvera pas tant que les chercheurs sur la fusion froide seront considérés comme des « pseudoscientifiques excentriques », dit Kowalski. « Le progrès est impossible et personne n’en profite lorsque les résultats d’une recherche honnête ne sont pas publiés et vérifiés de manière indépendante par d’autres laboratoires. »

Le temps nous montrera

Même si Kowalski obtient une réponse définitive à sa question et que les déclarations des chercheurs du LENR sont confirmées, le chemin vers la commercialisation de la technologie sera semé d'embûches. De nombreuses startups, même avec technologie fiable, échouent pour des raisons indépendantes de la science : capitalisation, flux de liquidités, coût, production, assurance, prix non compétitifs, etc.Prenez Sun Catalytix par exemple. L’entreprise a émergé du MIT avec le soutien de solides connaissances scientifiques, mais a été victime d’attaques commerciales avant d’arriver sur le marché. Il a été créé pour commercialiser la photosynthèse artificielle, développée par le chimiste Daniel G. Nocera, maintenant à Harvard, pour convertir efficacement l'eau en hydrogène en utilisant lumière du soleil et un catalyseur peu coûteux.

Nocera rêvait que l'hydrogène produit de cette manière pourrait alimenter de simples piles à combustible et alimenter des maisons et des villages dans des régions mal desservies du monde sans accès au réseau, leur permettant ainsi de profiter de commodités modernes qui amélioreraient leur niveau de vie. Mais le développement a pris beaucoup plus de temps et d’argent qu’il n’y paraissait au début. Après quatre ans, Sun Catalytix a renoncé à commercialiser cette technologie et s'est lancée dans la fabrication de batteries à flux, puis en 2014, elle a été rachetée par Lockheed Martin.

On ne sait pas si les mêmes obstacles entravent le développement des entreprises engagées dans le LENR. Par exemple, Wilk, un chimiste organique qui a suivi les progrès de Mills, se demande si les tentatives de commercialisation du BLP sont fondées sur quelque chose de réel. Il a juste besoin de savoir si l'hydrino existe.

En 2014, Wilk a demandé à Mills s'il avait isolé l'hydrino, et bien que Mills ait déjà écrit dans des articles et des brevets qu'il avait réussi, il a répondu qu'une telle chose n'avait pas encore été faite et que ce serait « une très grande tâche ». Mais Wilk pense différemment. Si le processus crée des litres d’hydrine gazeuse, cela devrait être évident. « Montrez-nous l'hydrino ! » demande Wilk.

Wilk dit que le monde de Mills, et avec lui celui des autres personnes impliquées dans LENR, lui rappelle l'un des paradoxes de Zeno, qui parle de la nature illusoire du mouvement. « Chaque année, ils arrivent à mi-chemin de la commercialisation, mais y parviendront-ils un jour ? Wilk a proposé quatre explications pour le BLP : les calculs de Mills sont corrects ; C'est une fraude ; C’est une mauvaise science ; c’est une science pathologique, comme l’a appelé le lauréat du prix Nobel de physique Irving Langmuir.

Langmuir a inventé le terme il y a plus de 50 ans pour décrire le processus psychologique par lequel un scientifique se retire inconsciemment de méthode scientifique et devient tellement immergé dans son métier qu'il développe l'incapacité de regarder les choses objectivement et de voir ce qui est réel et ce qui ne l'est pas. La science pathologique est « la science des choses qui ne sont pas ce qu’elles semblent être », a déclaré Langmuir. Dans certains cas, elle se développe dans des domaines comme la fusion froide/LENR, et n'abandonne pas, même si elle est reconnue comme fausse par la majorité des scientifiques.

"J'espère qu'ils ont raison", dit Wilk à propos de Mills et du BLP. "En effet. Je ne veux pas les réfuter, je cherche juste la vérité. Mais si « les cochons pouvaient voler », comme le dit Wilkes, il accepterait leurs données, théories et autres prédictions qui en découlent. Mais il n’a jamais été croyant. "Je pense que si les hydrinos existaient, ils auraient été découverts dans d'autres laboratoires ou dans la nature il y a de nombreuses années."

Toutes les discussions sur la fusion froide et le LENR se terminent exactement ainsi : elles arrivent toujours à la conclusion que personne n'a mis sur le marché un appareil fonctionnel et qu'aucun des prototypes ne peut être commercialisé dans un avenir proche. Le temps sera donc le dernier juge.

Mots clés:

- fusion froide

- non

- réactions nucléaires à faible énergie

- cellule solaire

- Russie

- e-chat

la fusion thermonucléaire, la réaction de fusion de noyaux atomiques légers en noyaux plus lourds, se produisant à des températures ultra-élevées et accompagnée de la libération d'énormes quantités d'énergie. La fusion nucléaire est une réaction inverse de la fission atomique : dans cette dernière, de l'énergie est libérée grâce à la division des noyaux lourds en noyaux plus légers. voir également FISSION DU NOYAU ; POUVOIR NUCLÉAIRE.

Selon les concepts astrophysiques modernes, la principale source d'énergie du Soleil et des autres étoiles est la fusion thermonucléaire qui se produit dans leurs profondeurs. En conditions terrestres, elle est réalisée lors d'une explosion Bombe à hydrogène. La fusion thermonucléaire s'accompagne d'une libération d'énergie colossale par unité de masse de substances en réaction (environ 10 millions de fois supérieure à celle des réactions chimiques). Il est donc d'un grand intérêt de maîtriser ce processus et, sur cette base, de créer un produit bon marché et respectueux de l'environnement. source pureénergie. Cependant, malgré le fait que les recherches fusion thermonucléaire(TCF) est occupé par d’importantes équipes scientifiques et techniques dans de nombreux pays développés, de nombreux problèmes complexes doivent encore être résolus avant que la production industrielle d’énergie thermonucléaire ne devienne une réalité.

Les centrales nucléaires modernes utilisant le processus de fission ne satisfont que partiellement les besoins mondiaux en électricité. Leur combustible est constitué d'éléments radioactifs naturels, l'uranium et le thorium, dont l'abondance et les réserves dans la nature sont très limitées ; par conséquent, de nombreux pays sont confrontés au problème de leur importation. Le principal composant du combustible thermonucléaire est le deutérium, un isotope de l’hydrogène, présent dans l’eau de mer. Ses réserves sont accessibles au public et très vastes (les océans du monde couvrent ~ 71 % de la superficie de la Terre et le deutérium représente environ 0,016 % nombre total atomes d'hydrogène qui composent l'eau). En plus de la disponibilité du combustible, les sources d'énergie thermonucléaires présentent les avantages importants suivants par rapport aux centrales nucléaires : 1) le réacteur UTS contient beaucoup moins de matières radioactives que réacteur atomique la fission, et donc les conséquences d'un rejet accidentel de produits radioactifs sont moins dangereuses ; 2) au thermo réactions nucléaires moins de déchets radioactifs à vie longue sont générés ; 3) TCB permet réception directeélectricité.

Artsimovitch L.A. Réactions thermonucléaires contrôlées. M., 1963

Thermique et nucléaire centrales

(livre 1, section 6 ; livre 3, section 8). M., 1989

Retrouvez "Fusion NUCLÉAIRE" sur

Chikanov A.S. // Journal pédagogique Soros, n° 8, 1997, pp : 86-91

Nous examinerons les principes physiques de la fusion thermonucléaire laser - un domaine scientifique en développement rapide, basé sur deux découvertes marquantes du 20e siècle : les réactions thermonucléaires et les lasers.

Les réactions thermonucléaires se produisent lors de la fusion (fusion) de noyaux d'éléments légers. Dans ce cas, parallèlement à la formation d'éléments plus lourds, un excès d'énergie est libéré sous forme d'énergie cinétique des produits de réaction finaux et de rayonnement gamma. L'importante libération d'énergie lors des réactions thermonucléaires attire l'attention des scientifiques en raison de la possibilité de leur application pratique dans des conditions terrestres. Ainsi, des réactions thermonucléaires à grande échelle ont été réalisées dans une bombe à hydrogène (ou thermonucléaire).

La possibilité d’utiliser l’énergie libérée lors des réactions thermonucléaires pour résoudre le problème énergétique semble extrêmement attractive. Le fait est que le combustible utilisé pour cette méthode de production d’énergie est l’isotope de l’hydrogène deutérium (D), dont les réserves dans l’océan mondial sont pratiquement inépuisables.

RÉACTIONS THERMONUCLÉAIRES ET fusion CONTRÔLÉE

Une réaction thermonucléaire est le processus de fusion (ou fusion) de noyaux légers en noyaux plus lourds. Puisque cela implique la formation de noyaux fortement liés à partir de noyaux plus lâches, le processus s’accompagne de la libération d’énergie de liaison. Le moyen le plus simple de fusionner est celui des isotopes de l'hydrogène - le deutérium D et le tritium T. Le noyau du deutérium - le deutéron contient un proton et un neutron. Le deutérium est contenu dans l'eau dans un rapport d'une partie pour 6 500 parties d'hydrogène. Le noyau du tritium, le triton, est constitué d'un proton et de deux neutrons. Le tritium est instable (demi-vie 12,4 ans), mais peut être produit par des réactions nucléaires.

La fusion des noyaux de deutérium et de tritium produit de l'hélium He avec une masse atomique de quatre et un neutron n. À la suite de la réaction, une énergie de 17,6 MeV est libérée.

La fusion des noyaux de deutérium se produit par deux canaux avec à peu près la même probabilité : dans le premier, du tritium et du proton p se forment et une énergie égale à 4 MeV est libérée ; dans le deuxième canal se trouvent de l'hélium de masse atomique 3 et un neutron, et l'énergie libérée est de 3,25 MeV. Ces réactions sont représentées sous forme de formules

D + T = 4He + n + 17,6 MeV,

D + D = T + p + 4,0 MeV,

D + D = 3He + n + 3,25 MeV.

Avant le processus de fusion, les noyaux de deutérium et de tritium ont une énergie d'environ 10 keV ; l'énergie des produits de réaction atteint des valeurs de l'ordre des unités et des dizaines de mégaélectronvolts. Il convient également de noter que la section efficace de la réaction D + T et sa vitesse d'apparition sont beaucoup plus élevées (des centaines de fois) que pour la réaction D + D. Par conséquent, pour la réaction D + T, elle est beaucoup plus facile à réaliser. conditions où l'énergie thermonucléaire libérée dépasse les coûts d'organisation des fusions de processus.

Des réactions de synthèse impliquant d'autres noyaux d'éléments (par exemple le lithium, le bore, etc.) sont également possibles. Cependant, les sections efficaces de réaction et leurs vitesses pour ces éléments sont nettement inférieures à celles des isotopes de l'hydrogène, et n'atteignent des valeurs notables que pour des températures de l'ordre de 100 keV. Atteindre de telles températures dans les installations thermonucléaires est actuellement totalement irréaliste, c'est pourquoi seules les réactions de fusion des isotopes de l'hydrogène peuvent avoir utilisation pratique bientôt.

Comment réaliser une réaction thermonucléaire ? Le problème est que la fusion des noyaux est empêchée par les forces de répulsion électrique. Conformément à la loi de Coulomb, la force de répulsion électrique croît inversement proportionnelle au carré de la distance entre les noyaux en interaction F ~ 1/ r 2. Par conséquent, pour la synthèse des noyaux, la formation de nouveaux éléments et la libération de l'excès d'énergie, il Il est nécessaire de surmonter la barrière coulombienne, c'est-à-dire de travailler contre les forces de répulsion, en conférant aux noyaux l'énergie nécessaire.

Il y a deux possibilités. L’un d’eux implique la collision de deux faisceaux d’atomes lumineux accélérés l’un vers l’autre. Il s’est toutefois avéré que cette méthode était inefficace. Le fait est que la probabilité de fusion de noyaux dans des faisceaux accélérés est extrêmement faible en raison de la faible densité de noyaux et du temps négligeable de leur interaction, bien que la création de faisceaux de l'énergie requise dans les accélérateurs existants ne pose pas de problème.

Une autre méthode choisie par les chercheurs modernes consiste à chauffer la substance à des températures élevées (environ 100 millions de degrés). Plus la température est élevée, plus l'énergie cinétique moyenne des particules est élevée et plus leur nombre est capable de franchir la barrière coulombienne.

Pour évaluer quantitativement l'efficacité des réactions thermonucléaires, un facteur de gain d'énergie Q est introduit égal à

où Eout est l'énergie libérée à la suite des réactions de fusion, Eust est l'énergie utilisée pour chauffer le plasma à des températures thermonucléaires.

Pour que l'énergie libérée à la suite de la réaction soit égale aux coûts énergétiques pour chauffer le plasma à des températures de l'ordre de 10 keV, il est nécessaire de remplir le critère dit de Lawson :

(Nt) 1014 $ s/cm3 pour la réaction D-T,

(Nt) 1 015 $ s/cm3 pour la réaction D-D.

Ici N est la densité du mélange deutérium-tritium (le nombre de particules par centimètre cube), t est le temps nécessaire aux réactions de synthèse pour se produire efficacement.

À ce jour, deux approches largement indépendantes ont émergé pour résoudre le problème de la fusion thermonucléaire contrôlée. Le premier d'entre eux repose sur la possibilité de confiner et d'isoler thermiquement un plasma à haute température de densité relativement faible (N © 1014-1015 cm-3) par un champ magnétique de configuration particulière pendant une durée relativement longue (t © 1- 10 s). De tels systèmes incluent le Tokamak (abréviation de « chambre toroïdale avec bobines magnétiques »), proposé dans les années 50 en URSS.

L’autre façon est l’impulsion. Avec l'approche pulsée, il est nécessaire de chauffer et de comprimer rapidement de petites portions de matière à des températures et des densités telles que les réactions thermonucléaires auraient le temps de se dérouler efficacement pendant l'existence d'un plasma non confiné ou, comme on dit, confiné par inertie. Les estimations montrent que pour comprimer une substance à des densités de 100 à 1 000 g/cm3 et la chauffer à une température T © 5-10 keV, il est nécessaire de créer une pression à la surface d'une cible sphérique P © 5 » 109 atm, c'est-à-dire qu'il faut une source qui permettrait à une énergie d'une densité de puissance de q © 1015 W/cm2 d'être fournie à la surface cible.

PRINCIPES PHYSIQUES DE LA FUSION THERMONUCLÉAIRE LASER

Pour la première fois l'idée d'utiliser des puissants rayonnement laser pour chauffer un plasma dense à des températures thermonucléaires a été proposé par N.G. Basov et O.N. Krokhin au début des années 60. À ce jour, une direction indépendante de la recherche thermonucléaire s'est formée : la fusion thermonucléaire laser (LTF).

Arrêtons-nous brièvement sur les principes physiques de base qui sont intégrés dans le concept d'atteinte diplômes élevés compression de substances et obtention de gains d'énergie importants grâce aux microexplosions laser. Nous baserons notre discussion sur l’exemple du mode dit de compression directe. Dans ce mode, une microsphère (Fig. 1), remplie de combustible thermonucléaire, est irradiée « uniformément » de tous les côtés par un laser multicanal. À la suite de l'interaction du rayonnement chauffant avec la surface cible, un plasma chaud avec une température de plusieurs kiloélectronvolts (appelé couronne de plasma) se forme, volant vers le faisceau laser avec des vitesses caractéristiques de 107 à 108 cm/s.

Sans pouvoir s'attarder plus en détail sur les processus d'absorption dans la couronne de plasma, notons que dans les expériences modèles modernes à des énergies de rayonnement laser de 10 à 100 kJ pour des cibles comparables en taille aux cibles pour des gains importants, il est possible d'atteindre des niveaux élevés. (© 90%) coefficients d'absorption du rayonnement thermique.

Comme nous l'avons déjà vu, rayonnement lumineux ne peut pas pénétrer les couches denses de la cible (la densité d'un solide est de © 1023 cm-3). En raison de la conductivité thermique, l'énergie absorbée dans un plasma avec une densité électronique inférieure à ncr est transférée vers des couches plus denses, où se produit l'ablation de la substance cible. Les couches non évaporées restantes de la cible, sous l'influence de la pression thermique et réactive, sont accélérées vers le centre, comprimant et chauffant le carburant qu'elles contiennent (Fig. 2). En conséquence, l'énergie du rayonnement laser est convertie au stade considéré en énergie cinétique de la matière volant vers le centre et en énergie de la couronne en expansion. Il est évident que énergie utile concentré en mouvement vers le centre. L'efficacité de la contribution de l'énergie lumineuse à la cible est caractérisée par le rapport de l'énergie spécifiée à l'énergie totale du rayonnement - ce qu'on appelle l'efficacité hydrodynamique (efficacité). Atteindre un rendement hydrodynamique suffisamment élevé (10-20 %) est l'un des questions importantes fusion thermonucléaire laser.

Riz. 2. Répartition radiale de la température et de la densité de matière dans la cible au stade d'accélération de la coque vers le centre

Quels processus peuvent empêcher l’obtention de taux de compression élevés ? L'un d'eux est qu'à des densités de rayonnement thermonucléaire q > 1014 W/cm2, une fraction importante de l'énergie absorbée n'est pas transformée en une onde de conductivité thermique électronique classique, mais en flux d'électrons rapides dont l'énergie est élevée. plus de température couronne de plasma (appelés électrons suprathermiques). Cela peut se produire à la fois en raison de l’absorption résonante et des effets paramétriques dans la couronne plasmatique. Dans ce cas, la longueur du trajet des électrons suprathermiques peut s'avérer comparable à la taille de la cible, ce qui entraînera un préchauffage du combustible compressible et l'impossibilité d'atteindre une compression maximale. Les quanta de rayons X à haute énergie (rayons X durs) accompagnant les électrons suprathermiques ont également une grande capacité de pénétration.

La tendance de la recherche expérimentale dernières années est la transition vers l'utilisation du rayonnement laser à ondes courtes (l< 0,5 мкм) при умеренных плотностях потока (q < 1015 Вт/см2). Практическая возможность перехода к нагреву плазмы коротковолновым излучением связана с тем, что коэффициенты конверсии излучения твердотельного неодимого лазера (основного кандидата в драйверы для лазерного термоядерного синтеза) с длиной волны l = 1,06 мкм в излучения второй, третьей и четвертой гармоник с помощью нелинейных кристаллов достигает 70-80%. В настоящее время фактически все крупные лазерные установки на неодимовом стекле снабжены системами умножения частоты. Физической причиной преимущества использования коротковолнового излучения для нагрева и сжатия микросфер является то, что с уменьшением длины волны увеличивается поглощение в плазменной короне и возрастают абляционное давление и гидродинамический коэффициент передачи. На несколько порядков уменьшается доля надтепловых электронов, генерируемых в плазменной короне, что является чрезвычайно выгодным для режимов как прямого, так и непрямого сжатия. Для непрямого сжатия принципиально и то, что с уменьшением длины волны увеличивается конверсия поглощенной плазмой энергии в мягкое рентгеновское излучение. Остановимся теперь на режиме непрямого сжатия. Физический анализ показывает, что осуществление режима сжатия до высоких плотностей топлива оптимально для простых и сложных оболочечных мишеней с аспектным отношением R / DR в несколько десятков. Здесь R — радиус оболочки, DR — ее толщина. Однако сильное сжатие может быть ограничено развитием гидродинамических неустойчивостей, которые проявляются в отклонении движения оболочки на стадиях ее ускорения и торможения в центре от сферической симметрии и зависят от отклонений начальной формы мишени от идеально сферической, неоднородного распределения падающих лазерных лучей по ее поверхности. Развитие неустойчивости при движении оболочки к центру приводит сначала к отклонению движения от сферически-симметричного, затем к турбулизации течения и в конце концов к перемешиванию слоев мишени и дейтериево-тритиевого горючего. В результате в конечном состоянии может возникнуть образование, форма которого резко отличается от сферического ядра, а средние плотность и температура значительно ниже величин, соответствующих одномерному сжатию. При этом начальная структура мишени (например, определенный набор слоев) может быть полностью нарушена. Физическая природа такого типа неустойчивости эквивалентна неустойчивости слоя ртути, находящегося на поверхности воды в поле тяжести. При этом, как известно, происходит полное перемешивание ртути и воды, то есть в конечном состоянии ртуть окажется внизу. Аналогичная ситуация и может происходить при ускоренном движении к центру вещества мишени, имеющей сложную структуру, или в общем случае при наличии градиентов плотности и давления. Требования к качеству мишеней достаточно жестки. Так, неоднородность толщины стенки микросферы не должна превышать 1%, однородность распределения поглощения энергии по поверхности мишени 0,5%. Предложение использовать схему непрямого сжатия как раз и связано с возможностью решить проблему устойчивости сжатия мишени. Diagramme schématique L'expérience en mode de compression indirecte est illustrée à la Fig. 3. Le rayonnement laser est dirigé dans la cavité (hohlraum), en se concentrant sur surface intérieure une enveloppe extérieure constituée d'une substance avec un numéro atomique élevé, comme l'or. Comme déjà indiqué, jusqu'à 80 % de l'énergie absorbée est transformée en rayonnement X doux, qui chauffe et comprime la coque interne. Les avantages d'un tel schéma incluent la possibilité d'obtenir une plus grande uniformité de la répartition de l'énergie absorbée sur la surface cible, la simplification de la conception du laser et des conditions de focalisation, etc. Cependant, il existe également des inconvénients liés à la perte d'énergie nécessaire à la conversion en rayonnement X et à la complexité d'introduction du rayonnement dans la cavité. Quel est l’état actuel de la recherche sur la fusion laser ? Les expériences visant à atteindre des densités élevées de carburant compressible en mode compression directe ont commencé au milieu des années 70 à l'Institut de physique. P.N. Lebedev, où la densité du deutérium compressible © 10 g/cm3 a été obtenue grâce à l'installation de Kalmar avec une énergie E = 200 J. Par la suite, des programmes de travail sur le LTS se sont activement développés aux États-Unis (installations Shiva, Nova au Livermore National Laboratory, Omega à l'Université de Rochester), au Japon (Gekko-12), en Russie (Dolphin au Lebedev Physical Institute, Iskra-4 ", "Iskra-5" dans Arzamas-16) à un niveau d'énergie laser de 1 à 100 kJ. Tous les aspects du chauffage et de la compression de cibles de diverses configurations en modes de compression directe et indirecte sont étudiés en détail. Des pressions d'ablation de ~100 Mbar et des vitesses d'effondrement des microsphères V > 200 km/s sont atteintes avec des valeurs d'efficacité hydrodynamique de l'ordre de 10 %. Les progrès dans le développement de systèmes laser et de conceptions de cibles ont permis d'assurer un degré d'uniformité d'irradiation d'une coque compressible de 1 à 2 % sous compression directe et indirecte. Dans les deux modes, les densités ont été atteintes gaz compressé 20-40 g/cm3, et à l'installation Gekko-12, une densité de coque comprimée de 600 g/cm3 a été enregistrée. Rendement maximal en neutrons N = 1014 neutrons par flash.

CONCLUSION

Ainsi, l'ensemble des résultats expérimentaux obtenus et leur analyse indiquent la faisabilité pratique de la prochaine étape du développement de la fusion thermonucléaire laser - atteindre des densités de gaz deutérium-tritium de 200 à 300 g/cm3, comprimer la cible et obtenir des facteurs de gain notables. k au niveau d'énergie E = 1 MJ (voir Fig. 4 et ).

Actuellement, la base d'éléments est intensivement développée et des projets d'installations laser au niveau mégajoule sont en cours de création. Le laboratoire Livermore a commencé la création d'une installation en verre néodyme d'énergie E = 1,8 MJ. Le coût du projet est de 2 milliards de dollars. La création d'une installation de niveau similaire est prévue en France. Avec cette installation, il est prévu d'atteindre un gain d'énergie de Q ~ 100. Il faut dire que le lancement d'installations de cette envergure rapprochera non seulement la possibilité de créer un réacteur thermonucléaire basé sur la fusion thermonucléaire laser, mais fournira également chercheurs avec un objet physique unique - une microexplosion avec une libération d'énergie de 107-109 J, source puissante neutron, neutrino, rayons X et rayonnement g. Cela aura non seulement une grande importance physique générale (capacité d'étudier des substances dans des états extrêmes, physique de la combustion, équations d'état, effets laser, etc.), mais permettra également de résoudre des problèmes particuliers d'ordre appliqué, notamment militaire, nature.

Cependant, pour un réacteur basé sur la fusion thermonucléaire laser, il est nécessaire de créer un laser de niveau mégajoule fonctionnant à un taux de répétition de plusieurs hertz. Plusieurs laboratoires étudient les possibilités de créer de tels systèmes basés sur de nouveaux cristaux. Le lancement du réacteur expérimental du programme américain est prévu pour 2025.

« Nous avons dit que nous mettrions le Soleil dans une boîte. L'idée est géniale. Mais le problème c'est qu'on ne sait pas comment créer cette boîte » - Pierre Gilles de Gennes, lauréat prix Nobel en physique 1991.

Alors que éléments lourds Il existe de nombreux éléments nécessaires aux réactions nucléaires sur Terre et dans l'espace en général ; il existe de nombreux éléments légers pour les réactions thermonucléaires sur Terre et dans l'espace. Par conséquent, l'idée d'utiliser l'énergie thermonucléaire au profit de l'humanité est venue presque immédiatement avec la compréhension des processus qui la sous-tendent - cela promettait des possibilités véritablement illimitées, puisque les réserves de combustible thermonucléaire sur Terre auraient dû suffire à des dizaines de milliers de les années à venir.

Déjà en 1951, deux directions principales sont apparues pour le développement des réacteurs thermonucléaires : Andrei Sakharov et Igor Tamm ont développé une architecture de tokamak dans laquelle la chambre de travail était un tore, tandis que Lyman Spitzer a proposé une architecture de conception plus complexe dont la forme rappelle le plus celle d'un réacteur thermonucléaire. bande de Mobius inversée non pas une, mais plusieurs fois.

La simplicité de la conception fondamentale du tokamak a permis longue durée développer cette direction en améliorant les caractéristiques des aimants conventionnels et supraconducteurs, ainsi qu'en augmentant progressivement la taille du réacteur. Mais avec l'augmentation des paramètres du plasma, des problèmes de comportement instable ont progressivement commencé à apparaître, ce qui a ralenti le processus.

La complexité de la conception du stellateur a complètement conduit au fait qu'après les premières expériences dans les années 50, le développement de cette direction s'est arrêté pendant longtemps. Il a reçu un nouveau souffle tout récemment avec l'avènement de systèmes modernes conception assistée par ordinateur, qui a permis de concevoir le stellateur Wendelstein 7-X avec les paramètres et la précision de conception nécessaires à son fonctionnement.

Physique du processus et problèmes de sa mise en œuvre

Les atomes de fer ont une énergie de liaison maximale par nucléon, c'est-à-dire une mesure de l'énergie qui doit être dépensée pour diviser un atome en ses neutrons et protons constitutifs, divisée par leur nombre total. Tous les atomes de masse inférieure et supérieure ont cet indicateur en dessous du fer :

Dans le même temps, dans les réactions thermonucléaires de fusion d'atomes légers jusqu'au fer, de l'énergie est libérée et la masse de l'atome résultant devient légèrement inférieur au montant masses des atomes initiaux d'une quantité qui est en corrélation avec l'énergie libérée selon la formule E=mc² (le soi-disant défaut de masse). De la même manière, de l’énergie est libérée lors des réactions de fission nucléaire d’atomes plus lourds que le fer.

Dans le même temps, dans les réactions thermonucléaires de fusion d'atomes légers jusqu'au fer, de l'énergie est libérée et la masse de l'atome résultant devient légèrement inférieur au montant masses des atomes initiaux d'une quantité qui est en corrélation avec l'énergie libérée selon la formule E=mc² (le soi-disant défaut de masse). De la même manière, de l’énergie est libérée lors des réactions de fission nucléaire d’atomes plus lourds que le fer.

Lors des réactions de fusion d'atomes, une énorme énergie est libérée, mais pour extraire cette énergie, il faut d'abord faire un certain effort pour vaincre les forces répulsives entre noyaux atomiques qui sont chargés positivement (surmonter la barrière coulombienne). Une fois que nous avons réussi à rapprocher une paire d’atomes de la distance requise, une force puissante entre en jeu. interaction nucléaire, qui relie les neutrons et les protons. Pour chaque type de carburant, la barrière coulombienne pour le début d'une réaction est différente, tout comme la température optimale de réaction est différente :

Dans ce cas, les premières réactions thermonucléaires des atomes commencent à être enregistrées bien avant d'atteindre température moyenne substances de cette barrière du fait que l'énergie cinétique des atomes est soumise à la distribution de Maxwell :

Dans ce cas, les premières réactions thermonucléaires des atomes commencent à être enregistrées bien avant d'atteindre température moyenne substances de cette barrière du fait que l'énergie cinétique des atomes est soumise à la distribution de Maxwell :

Mais la réaction à une température relativement basse (de l’ordre de plusieurs millions de °C) se déroule extrêmement lentement. Disons qu’au centre la température atteint 14 millions de °C, mais la puissance spécifique de la réaction thermonucléaire dans de telles conditions n’est que de 276,5 W/m³, et il faut au Soleil plusieurs milliards d’années pour consommer complètement son combustible. De telles conditions sont inacceptables pour un réacteur thermonucléaire, car à un niveau de libération d'énergie aussi faible, nous dépenserons inévitablement plus pour chauffer et comprimer le combustible thermonucléaire que ce que nous recevrons de la réaction en retour.

Mais la réaction à une température relativement basse (de l’ordre de plusieurs millions de °C) se déroule extrêmement lentement. Disons qu’au centre la température atteint 14 millions de °C, mais la puissance spécifique de la réaction thermonucléaire dans de telles conditions n’est que de 276,5 W/m³, et il faut au Soleil plusieurs milliards d’années pour consommer complètement son combustible. De telles conditions sont inacceptables pour un réacteur thermonucléaire, car à un niveau de libération d'énergie aussi faible, nous dépenserons inévitablement plus pour chauffer et comprimer le combustible thermonucléaire que ce que nous recevrons de la réaction en retour.

À mesure que la température du carburant augmente, une proportion croissante d’atomes commencent à avoir une énergie dépassant la barrière coulombienne et l’efficacité de la réaction augmente, atteignant son apogée. Avec une nouvelle augmentation de la température, la vitesse de réaction recommence à baisser car l'énergie cinétique des atomes devient trop élevée et ils se « dépassent » les uns les autres, incapables d'être maintenus ensemble par la forte interaction nucléaire.

Ainsi, la solution pour obtenir de l'énergie à partir d'une réaction thermonucléaire contrôlée a été obtenue assez rapidement, mais la mise en œuvre de cette tâche a duré un demi-siècle et n'est pas encore achevée. La raison en est les conditions véritablement insensées dans lesquelles il s'est avéré nécessaire de placer combustible thermonucléaire– pour un rendement positif de la réaction, sa température aurait dû être de plusieurs dizaines de millions de °C.

Aucun mur ne pouvait physiquement résister à une telle température, mais ce problème a presque immédiatement conduit à sa solution : puisqu'une substance chauffée à de telles températures est un plasma chaud (gaz entièrement ionisé) chargé positivement, la solution s'est avérée être à la surface - il suffisait de placer un tel plasma chauffé dans un champ magnétique puissant, qui maintiendrait le combustible thermonucléaire à Distance de sécurité des murs.

Progrès vers sa mise en œuvre

Les recherches sur ce sujet vont dans plusieurs directions à la fois :

- En utilisant des aimants supraconducteurs, les scientifiques tentent de réduire l'énergie dépensée pour allumer et entretenir la réaction ;

- à l'aide de nouvelles générations de supraconducteurs, l'induction du champ magnétique à l'intérieur du réacteur augmente, ce qui permet de contenir du plasma avec des densités et des températures plus élevées, ce qui augmente la densité de puissance réacteurs par unité de leur volume ;

- recherche dans le domaine du plasma chaud et avancées dans le domaine la technologie informatique permettre un meilleur contrôle des flux de plasma, rapprochant ainsi les réacteurs à fusion de leurs limites théoriques d'efficacité ;

- Les progrès dans le domaine précédent nous permettent également de maintenir le plasma dans un état stable plus longtemps, ce qui augmente l'efficacité du réacteur du fait que nous n'avons pas besoin de réchauffer le plasma aussi souvent.

Malgré toutes les difficultés et les problèmes qui se posent sur la voie d'une réaction thermonucléaire contrôlée, cette histoire touche déjà à sa fin. Dans l'industrie énergétique, il est d'usage d'utiliser l'indicateur EROEI - retour énergétique sur investissement énergétique (le rapport de l'énergie dépensée dans la production de carburant à la quantité d'énergie que nous en obtenons finalement) pour calculer l'efficacité énergétique. Et tandis que l'EROEI du charbon continue de croître, cet indicateur du pétrole et du gaz a atteint son apogée au milieu du siècle dernier et est désormais en baisse constante du fait que de nouveaux gisements de ces combustibles se trouvent de plus en plus endroits difficiles d'accès et à des profondeurs toujours plus grandes :

Dans le même temps, nous ne pouvons pas non plus augmenter la production de charbon, car en tirer de l’énergie est un processus très sale qui coûte littéralement la vie à des personnes. diverses maladies poumons. D'une manière ou d'une autre, nous nous trouvons désormais au seuil de la fin de l'ère des combustibles fossiles - et il ne s'agit pas de machinations d'écologistes, mais de calculs économiques banals lorsqu'on regarde vers l'avenir. Dans le même temps, l'EROI des réacteurs thermonucléaires expérimentaux, également apparus au milieu du siècle dernier, a augmenté régulièrement et a atteint en 2007 la barrière psychologique d'un - c'est-à-dire que cette année, pour la première fois, l'humanité a réussi à obtenir plus d'énergie. par une réaction thermonucléaire qu'il n'a dépensé pour sa mise en œuvre. Et malgré le fait que la mise en œuvre du réacteur, ses expérimentations et la production de la première centrale thermonucléaire de démonstration DEMO basée sur l'expérience acquise lors de la mise en œuvre d'ITER prendront encore beaucoup de temps. Il ne fait plus aucun doute que notre avenir réside dans de tels réacteurs.

Dans le même temps, nous ne pouvons pas non plus augmenter la production de charbon, car en tirer de l’énergie est un processus très sale qui coûte littéralement la vie à des personnes. diverses maladies poumons. D'une manière ou d'une autre, nous nous trouvons désormais au seuil de la fin de l'ère des combustibles fossiles - et il ne s'agit pas de machinations d'écologistes, mais de calculs économiques banals lorsqu'on regarde vers l'avenir. Dans le même temps, l'EROI des réacteurs thermonucléaires expérimentaux, également apparus au milieu du siècle dernier, a augmenté régulièrement et a atteint en 2007 la barrière psychologique d'un - c'est-à-dire que cette année, pour la première fois, l'humanité a réussi à obtenir plus d'énergie. par une réaction thermonucléaire qu'il n'a dépensé pour sa mise en œuvre. Et malgré le fait que la mise en œuvre du réacteur, ses expérimentations et la production de la première centrale thermonucléaire de démonstration DEMO basée sur l'expérience acquise lors de la mise en œuvre d'ITER prendront encore beaucoup de temps. Il ne fait plus aucun doute que notre avenir réside dans de tels réacteurs.