Mécanique quantique et théorie quantique des champs. Que dit réellement la théorie quantique de la réalité ? Attention! Passons maintenant à un problème plus subtil

Lire aussi

Et surtout, nous refusons de remarquer qu'ils ne sont applicables que dans certaines situations de routine et qu'ils s'avèrent tout simplement incorrects pour expliquer la structure de l'Univers.

Bien que quelque chose de similaire ait été exprimé il y a des siècles par des philosophes et des mystiques orientaux, Einstein a été le premier à en parler dans la science occidentale. C'était une révolution que notre conscience n'acceptait pas. Nous répétons avec condescendance : « tout est relatif », « le temps et l’espace ne font qu’un », en gardant toujours à l’esprit qu’il s’agit d’une hypothèse, d’une abstraction scientifique qui a peu de points communs avec notre réalité stable habituelle. En fait, ce sont précisément nos idées qui correspondent mal à la réalité - étonnantes et incroyables.

Après dans Plan général La structure de l'atome a été découverte et son modèle « planétaire » a été proposé, les scientifiques ont été confrontés à de nombreux paradoxes, pour expliquer lesquels est apparue toute une branche de la physique - la mécanique quantique. Il s'est développé rapidement et a fait de grands progrès dans l'explication de l'Univers. Mais ces explications sont si difficiles à comprendre que jusqu’à présent, peu de gens peuvent les comprendre, au moins en termes généraux.

En effet, la plupart des réalisations mécanique quantique sont accompagnés d’un appareil mathématique si complexe qu’il ne peut tout simplement pas être traduit dans un langage humain. Les mathématiques, comme la musique, sont un sujet extrêmement abstrait, et les scientifiques ont encore du mal à exprimer de manière adéquate la signification, par exemple, de la convolution des fonctions ou des séries de Fourier multidimensionnelles. Le langage mathématique est strict, mais n’a que peu de rapport avec notre perception directe.

De plus, Einstein a démontré mathématiquement que nos concepts de temps et d’espace sont illusoires. En réalité, l’espace et le temps sont indissociables et forment un seul continuum quadridimensionnel. Il est difficilement possible de l’imaginer, car nous sommes habitués à n’avoir affaire qu’à trois dimensions.

Théorie planétaire. Vague ou particule

Avant fin XIX Pendant des siècles, les atomes étaient considérés comme des « éléments » indivisibles. La découverte des rayonnements a permis à Rutherford de pénétrer sous la « coquille » de l'atome et de formuler une théorie planétaire de sa structure : la majeure partie de l'atome est concentrée dans le noyau. La charge positive du noyau est compensée par des électrons chargés négativement, dont la taille est si petite que leur masse peut être négligée. Les électrons tournent autour du noyau sur des orbites similaires à la rotation des planètes autour du Soleil. La théorie est très belle, mais un certain nombre de contradictions surgissent.

Premièrement, pourquoi les électrons chargés négativement ne « tombent »-ils pas sur le noyau positif ? Deuxièmement, dans la nature, les atomes entrent en collision des millions de fois par seconde, ce qui ne leur nuit pas du tout - comment expliquer la force incroyable de l'ensemble du système ? Selon les mots de l’un des « pères » de la mécanique quantique, Heisenberg, « aucun système planétaire obéissant aux lois de la mécanique newtonienne ne reviendra jamais à son état d’origine après une collision avec un autre système similaire ».

De plus, les dimensions du noyau, dans lequel est collectée presque toute la masse, sont extrêmement petites par rapport à l’atome entier. On peut dire qu’un atome est un vide dans lequel les électrons tournent à une vitesse vertigineuse. Dans ce cas, un tel atome « vide » apparaît comme une particule très solide. L’explication de ce phénomène dépasse la compréhension classique. En effet, au niveau subatomique, la vitesse d’une particule augmente à mesure que l’espace dans lequel elle se déplace est plus limité. Ainsi, plus un électron est attiré près du noyau, plus il se déplace vite et plus il en est repoussé. La vitesse de déplacement est si élevée que « de l'extérieur » l'atome « semble solide », tout comme les pales d'un ventilateur en rotation ressemblent à un disque.

Des données qui ne rentrent pas bien dans le cadre de l’approche classique sont apparues bien avant Einstein. Pour la première fois, un tel « duel » a eu lieu entre Newton et Huygens, qui tentaient d'expliquer les propriétés de la lumière. Newton affirmait qu'il s'agissait d'un flux de particules, Huygens considérait la lumière comme une onde. Dans le cadre de la physique classique, il est impossible de concilier leurs positions. Après tout, pour elle, une onde est une excitation transmise de particules du milieu, concept applicable uniquement à de nombreux objets. Aucune des particules libres ne peut se déplacer le long d’une trajectoire ondulatoire. Mais un électron se déplace dans un vide profond et ses mouvements sont décrits par les lois du mouvement ondulatoire. Qu'est-ce qui est excité ici s'il n'y a pas de support ? La physique quantique propose une solution salomonienne : la lumière est à la fois une particule et une onde.

Nuages électroniques probabilistes. Structure nucléaire et particules nucléaires

Peu à peu, cela est devenu de plus en plus clair : la rotation des électrons en orbite autour du noyau d'un atome est complètement différente de la rotation des planètes autour d'une étoile. De nature ondulatoire, les électrons sont décrits en termes de probabilité. On ne peut pas dire d'un électron qu'il se situe en tel ou tel point de l'espace, on ne peut que décrire approximativement dans quelles zones il peut se situer et avec quelle probabilité. Autour du noyau, les électrons forment des « nuages » de probabilités allant des formes sphériques les plus simples aux formes les plus bizarres, semblables à des photographies de fantômes.

Mais quiconque veut enfin comprendre la structure de l’atome doit se tourner vers sa base, vers la structure du noyau. Les grosses particules élémentaires qui le composent - des protons chargés positivement et des neutrons neutres - ont également une nature quantique, ce qui signifie qu'elles se déplacent d'autant plus vite que le volume dans lequel elles sont enfermées est petit. Les dimensions du noyau étant extrêmement petites, même en comparaison avec un atome, ces particules élémentaires se déplacent à des vitesses tout à fait décentes, proches de la vitesse de la lumière. Pour une explication finale de leur structure et de leur comportement, il faudra « croiser » la théorie quantique avec la théorie de la relativité. Malheureusement, une telle théorie n’a pas encore été créée et nous devrons nous limiter à quelques modèles généralement acceptés.

La théorie de la relativité a montré (et les expériences l’ont prouvé) que la masse n’est qu’une forme d’énergie. L'énergie est une quantité dynamique associée aux processus ou au travail. Ainsi, une particule élémentaire doit être perçue comme une fonction dynamique probabiliste, comme des interactions associées à la transformation continue de l'énergie. Cela donne une réponse inattendue à la question de savoir comment sont les particules élémentaires et si elles peuvent être divisées en blocs « encore plus simples ». Si nous accélérons deux particules dans un accélérateur puis les heurtons, nous obtiendrons non pas deux, mais trois particules, complètement identiques. Le troisième naîtra simplement de l’énergie de leur collision – ainsi, ils se sépareront et ne se sépareront pas en même temps !

Participant au lieu d’observateur

Dans un monde où les concepts d’espace vide et de matière isolée perdent leur sens, une particule n’est décrite qu’à travers ses interactions. Pour en dire quelque chose, nous devrons l'« arracher » aux interactions initiales et, après l'avoir préparé, le soumettre à une autre interaction : la mesure. Alors, que mesure-t-on au final ? Et dans quelle mesure nos mesures sont-elles légitimes en général si notre intervention modifie les interactions auxquelles la particule participe - et donc change la particule elle-même ?

En physique moderne particules élémentaires La figure même du scientifique-observateur suscite de plus en plus de critiques. Il serait plus approprié de l’appeler un « participant ».

Un observateur-participant est nécessaire non seulement pour mesurer les propriétés d'une particule subatomique, mais aussi pour déterminer ces mêmes propriétés, car elles ne peuvent être discutées que dans le contexte d'une interaction avec l'observateur. Une fois qu'il a choisi la méthode dans laquelle il effectuera les mesures, et en fonction de cela, les propriétés possibles de la particule sont réalisées. Si vous changez de système d'observation, les propriétés de l'objet observé changeront également.

Ce moment important révèle l’unité profonde de toutes choses et phénomènes. Les particules elles-mêmes, qui se transforment continuellement les unes en les autres et en d'autres formes d'énergie, n'ont pas de caractéristiques constantes ou précises ; ces caractéristiques dépendent de la manière dont nous choisissons de les voir. Si vous devez mesurer une propriété d’une particule, une autre changera certainement. Une telle limitation n’est pas liée à l’imperfection des appareils ou à d’autres choses totalement corrigibles. C'est une caractéristique de la réalité. Essayez de mesurer avec précision la position d'une particule et vous ne pourrez rien dire sur la direction et la vitesse de son mouvement - tout simplement parce qu'elle ne les aura pas. Décrivez le mouvement exact d'une particule - vous ne le trouverez pas dans l'espace. Donc physique moderne nous pose des problèmes d’ordre tout à fait métaphysique.

Le principe d'incertitude. Lieu ou impulsion, énergie ou temps

Nous avons déjà dit que nous ne pouvons pas parler de particules subatomiques dans les termes précis auxquels nous sommes habitués ; dans le monde quantique, il ne nous reste que des probabilités. Bien entendu, ce n’est pas le genre de probabilité dont parlent les gens lorsqu’ils parient sur des courses de chevaux, mais une propriété fondamentale des particules élémentaires. Ce n’est pas qu’ils existent, mais ils peuvent exister. Ce n’est pas qu’ils aient des caractéristiques, mais plutôt qu’ils puissent les avoir. Scientifiquement parlant, une particule est un circuit probabiliste dynamique, et toutes ses propriétés sont en équilibre en mouvement constant, s'équilibrant comme le Yin et le Yang dans l'Antiquité. symbole chinois Taï chi.

Ce n’est pas pour rien que le prix Nobel Niels Bohr, élevé au rang de noblesse, a choisi ce signe et cette devise pour son blason : « Les opposés se complètent ». Mathématiquement, la distribution de probabilité représente des oscillations d'ondes inégales. Plus l'amplitude d'une onde est grande à un certain endroit, plus la probabilité qu'une particule y existe est élevée. De plus, sa longueur n'est pas constante - les distances entre les crêtes adjacentes ne sont pas les mêmes, et plus l'amplitude de la vague est élevée, plus la différence entre elles est grande. Alors que l'amplitude correspond à la position de la particule dans l'espace, la longueur d'onde est liée à l'impulsion de la particule, c'est-à-dire à la direction et à la vitesse de son mouvement. Plus l'amplitude est grande (plus la particule peut être localisée avec précision dans l'espace), plus la longueur d'onde devient incertaine (moins on peut en dire sur l'impulsion de la particule). Si nous pouvons déterminer la position d’une particule avec une extrême précision, elle n’aura aucun élan défini.

Cette propriété fondamentale est dérivée mathématiquement des propriétés des ondes et est appelée principe d'incertitude. Le principe s'applique également à d'autres caractéristiques des particules élémentaires. Une autre paire interconnectée est l’énergie et le temps des processus quantiques. Plus le processus est rapide, plus la quantité d'énergie impliquée est incertaine, et vice versa - l'énergie ne peut être caractérisée avec précision que pour un processus d'une durée suffisante.

Nous comprenons donc : rien de précis ne peut être dit sur une particule. Il se déplace par ici, ou pas par là, ou plutôt ni par ici ni par là. Ses caractéristiques sont ceci ou cela, ou plutôt pas ceci ou cela. Il est ici, mais il se peut qu'il soit là ou qu'il ne soit nulle part. Alors, est-ce que ça existe ?

Cet effondrement de la fonction d'onde, apparemment induit par des mesures, a été à l'origine de nombreuses difficultés conceptuelles en mécanique quantique. Avant l’effondrement, il n’y a aucun moyen de savoir avec certitude où finira le photon ; cela peut être n'importe où avec une probabilité non nulle. Il n’existe aucun moyen de retracer le chemin d’un photon de la source au détecteur. Un photon est irréel, tout comme un avion volant de San Francisco à New York est réel.

Werner Heisenberg, entre autres, a interprété ces mathématiques comme signifiant que la réalité n'existe pas tant qu'elle n'est pas observée. "L'idée d'un monde réel objectif, dont les plus petites particules existent objectivement dans le même sens que les pierres ou les arbres, que nous les observions ou non, est impossible", a-t-il écrit. John Wheeler a également utilisé une variante de l’expérience à double fente pour affirmer qu’« aucun phénomène quantique élémentaire n’est un phénomène jusqu’à ce qu’il devienne un phénomène enregistré (« observable », « enregistré de manière fiable »).

Mais la théorie quantique ne donne absolument aucun indice sur ce qui constitue une « mesure ». Il postule simplement que l’appareil de mesure doit être classique, sans définir où se situe la frontière entre classique et quantique, et en laissant la porte ouverte à ceux qui croient que l’effondrement est causé par la conscience humaine. En mai dernier, Henry Stapp et ses collègues annonçaient que l'expérience de la double fente et ses options modernes suggèrent qu'« un observateur conscient peut être nécessaire » pour donner un sens au domaine quantique, et que fondamentalement monde matériel réside l’esprit transpersonnel.

Mais ces expériences ne fournissent pas de preuves empiriques pour de telles affirmations. L’expérience à double fente, réalisée avec des photons uniques, ne peut tester que les prédictions probabilistes des mathématiques. Si des probabilités émergent du processus d’envoi de dizaines de milliers de photons identiques à travers une double fente, la théorie affirme que la fonction d’onde de chaque photon s’est effondrée – grâce à un processus vaguement défini appelé mesure. C'est tout.

De plus, il existe d’autres interprétations de l’expérience de la double fente. Prenons par exemple la théorie de Broglie-Bohm, qui affirme que la réalité est à la fois une onde et une particule. Le photon est dirigé vers la double fente avec une certaine position à tout moment et passe par l'une ou l'autre fente ; donc chaque photon a une trajectoire. Il traverse une onde pilote qui pénètre dans les deux fentes, interfère puis dirige le photon vers le site d'interférence constructive.

En 1979, Chris Dewdney et ses collègues du Brickbeck College de Londres ont modélisé la prédiction de cette théorie sur les trajectoires des particules qui passeraient par la double fente. Au cours des dix dernières années, les expérimentateurs ont confirmé l’existence de telles trajectoires, bien qu’ils aient utilisé la technique controversée des mesures dites faibles. Bien que controversée, des expériences ont montré que la théorie de Broglie-Bohm est toujours capable d'expliquer le comportement du monde quantique.

Plus important encore, cette théorie ne nécessite ni observateurs, ni mesures, ni conscience immatérielle.

Tout comme les théories dites d'effondrement ne sont pas nécessaires, d'où il résulte que les fonctions d'onde s'effondrent de manière aléatoire : plus le nombre de particules dans un système quantique est grand, plus l'effondrement est probable. Les observateurs enregistrent simplement le résultat. L'équipe de Markus Arndt de l'Université de Vienne en Autriche a testé ces théories en envoyant des molécules de plus en plus grosses à travers une double fente. Les théories de l’effondrement prédisent que lorsque les particules de matière deviennent plus massives qu’un certain seuil, elles ne peuvent plus rester en superposition quantique et traverser les deux fentes simultanément, ce qui détruit le motif d’interférence. L'équipe d'Arndt a envoyé une molécule de 800 atomes à travers une double fente et a quand même vu des interférences. La recherche du seuil se poursuit.

Roger Penrose avait sa propre version de la théorie de l'effondrement, dans laquelle plus la masse d'un objet en superposition est élevée, plus il s'effondre rapidement dans un état ou un autre en raison des instabilités gravitationnelles. Encore une fois, cette théorie ne nécessite ni observateur ni conscience. Dirk Bouwmeester, de l'Université de Californie à Santa Barbara, teste l'idée de Penrose en utilisant une version de l'expérience à double fente.

Conceptuellement, l'idée n'est pas seulement de mettre un photon en superposition en passant par deux fentes en même temps, mais de mettre l'une des fentes en superposition et de la forcer à se trouver à deux endroits en même temps. Selon Penrose, l'espace remplacé restera en superposition ou s'effondrera avec le photon en vol, conduisant à différents modèles d'interférence. Cet effondrement dépendra de la masse des fissures. Bouwmeester travaille sur cette expérience depuis dix ans et pourrait bientôt confirmer ou infirmer les affirmations de Penrose.

Quoi qu’il en soit, ces expériences montrent que nous ne pouvons encore faire aucune déclaration sur la nature de la réalité, même si ces affirmations sont bien étayées mathématiquement ou philosophiquement. Et étant donné que les neuroscientifiques et les philosophes de l'esprit ne peuvent s'entendre sur la nature de la conscience, l'affirmation selon laquelle elle conduit à l'effondrement fonctions d'onde, sera au mieux prématuré et au pire erroné.

Quel est ton opinion? Dites-nous dans notre

THÉORIE QUANTIQUE DES CHAMPS.

1. Champs quantiques.................... 300

2. Champs libres et dualité onde-particule.................................. 301

3. Interaction des champs.........302

4. Théorie des perturbations............... 303

5. Divergences et renormalisations......... 304

6. Groupe asymptotique UV et renormalisation......... 304

7. Champs d'étalonnage........................ 305

8. Vue d'ensemble.............. 307

9. Perspectives et problèmes............ 307

Théorie quantique des champs(QFT) - théorie quantique des systèmes relativistes avec un nombre infini de degrés de liberté (champs relativistes), qui est une théorie la base pour décrire les microparticules, leurs interactions et interconversions.

1. Champs quantiques Le champ quantique (sinon quantifié) est une sorte de synthèse de concepts classiques. des domaines tels que l'électromagnétique et le champ de probabilité de la mécanique quantique. Selon le moderne idées, le champ quantique est la forme la plus fondamentale et la plus universelle de la matière, sous-jacente à toutes ses manifestations spécifiques. L'idée d'un classique le domaine est né dans les profondeurs de la théorie de Faraday-Maxwell de l'électromagnétisme et s'est finalement cristallisé dans le processus de création spéciale. théorie de la relativité, qui a nécessité l'abandon éther comme support matériel d'el-magn. processus. Dans ce cas, le champ ne devait pas être considéré comme une forme de mouvement de la cellule. environnement, mais spécifique. une forme de matière aux propriétés très inhabituelles. Contrairement aux particules, les classiques le champ est continuellement créé et détruit (émis et absorbé par des charges), possède un nombre infini de degrés de liberté et n'est pas localisé de manière spécifique. points de l'espace-temps, mais peut s'y propager, transmettant un signal (interaction) d'une particule à une autre avec une vitesse finie ne dépassant pas Avec. L'émergence des idées quantiques a conduit à une révision du classique. des idées sur la continuité du mécanisme d'émission et la conclusion que ces processus se produisent discrètement - à travers l'émission et l'absorption de quanta électro-magnétiques. champs - photons. Surgit contradictoire du point de vue du classique. image physique avec el-magn. les photons étaient comparés par le champ et certains phénomènes ne pouvaient être interprétés qu'en termes d'ondes, tandis que d'autres - uniquement à l'aide de l'idée de quanta, appelés dualité onde-particule. Cette contradiction a été résolue par la suite. application des idées de la mécanique quantique au domaine. Dynamique variable el-magn. champs - potentiels UN

, j et l'intensité électrique. et mag. des champs E

, N

- devenir opérateurs quantiques, sous réserve de définition. relations de commutation et agissant sur la fonction d'onde (amplitude, ou vecteur d'état)systèmes. Ainsi, une nouvelle science physique est née. objet - un champ quantique qui satisfait les équations classiques. , mais qui a des significations en mécanique quantique. les opérateurs. La deuxième source du concept général de champ quantique était la fonction d'onde de la particule y ( x, t), Edge n'est pas une entité physique indépendante. magnitude, et l'amplitude de l'état de la particule : les probabilités de tout lien avec la physique de la particule. les quantités sont exprimées par des expressions bilinéaires en y. Ainsi, en mécanique quantique, un nouveau champ – un champ d’amplitudes de probabilité – était associé à chaque particule matérielle. La généralisation relativiste de la fonction y a conduit P. A. M. Dirac (R. A. M. Dirac) à la fonction d'onde à quatre composantes de l'électron y a (a = 1, 2, 3, 4), se transformant selon la représentation du spineur Groupe Lorentz. On s'est vite rendu compte qu'en général, chaque département. une microparticule relativiste doit être associée à un champ local qui implémente une certaine représentation du groupe de Lorentz et possède un champ physique. signification de l’amplitude de probabilité. Généralisation au cas pluriel. les particules ont montré que si elles satisfont au principe d'indiscernabilité ( identité avec le principe), alors pour décrire toutes les particules, un champ dans l'espace-temps à quatre dimensions suffit, ce qui est un opérateur au sens de . Ceci est réalisé grâce à la transition vers une nouvelle mécanique quantique. représentation - représentation des nombres de remplissage (ou représentation des nombres secondaires quantification). Le champ opérateur ainsi introduit s’avère tout à fait analogue au champ électrique quantifié. champ, n'en différant que par le choix de la représentation du groupe de Lorentz et, éventuellement, par la méthode de quantification. Comme El-Magn. champ, un de ces champs correspond à l'ensemble des particules identiques d'un type donné, par exemple, un opérateur Champ de Dirac décrit tous les électrons (et positrons !) de l’Univers. C'est ainsi qu'apparaît une image universelle de la structure uniforme de toute matière. Pour remplacer les champs et les particules du classique les physiciens viennent unis en physique. objets - champs quantiques dans un espace-temps à quatre dimensions, un pour chaque type de particule ou de champ (classique). L'acte élémentaire de toute interaction est l'interaction de plusieurs. champs en un point de l'espace-temps, ou - en langage corpusculaire - transformation locale et instantanée de certaines particules en d'autres. Classique L'interaction sous forme de forces agissant entre particules s'avère être un effet secondaire résultant de l'échange de quanta du champ porteur de l'interaction.

2. Champs libres et dualité onde-particule Conformément à l’image physique générale brièvement décrite ci-dessus. image de manière systématique. La présentation de QFT peut être basée à la fois sur des concepts de terrain et corpusculaires. Dans l’approche de terrain, il faut d’abord construire une théorie à partir de la théorie classique correspondante. champ, puis le soumettre à une quantification [sur le modèle de quantification d'el-magn. champs par W. Heisenberg et W. Pauli] et, enfin, développer une interprétation corpusculaire du champ quantifié résultant. Le principal concept initial ici sera le champ et un(X) (indice UN numérote les composants du champ) définis à chaque point spatio-temporel x=(ct,x) et en exécutant k--l. une représentation assez simple du groupe de Lorentz. La théorie ultérieure peut être construite plus facilement en utilisant Formalisme lagrangien ; choisissez local [c.-à-d. c'est-à-dire en fonction uniquement des composants du champ et un(X) et leurs premières dérivées d m et un(X)=du a / dx m = et un m( X) (m=0, 1, 2, 3) à un moment donné X] quadratique invariant de Poincaré (voir. Groupe Poincaré) Lagrangien L(x) = L(u a , d m tu b) et de principe de moindre action obtenir les équations du mouvement. Pour un lagrangien quadratique, ils sont linéaires – les champs libres satisfont au principe de superposition. En vertu de Théorème de Noether de l’invariance de l’action S par rapport à chaque paramètre. le groupe suit la conservation (indépendance du temps) de l'un, explicitement indiquée par le théorème, fonction intégrale de et un Et d m tu b. Puisque le groupe de Poincaré lui-même est à 10 paramètres, QFT préserve nécessairement 10 quantités, parfois appelées fundams. dynamique quantités : de l'invariance par rapport à quatre déplacements dans l'espace-temps à quatre dimensions, découle la conservation de quatre composantes du vecteur énergie-impulsion R. m , et de l'invariance sous six rotations dans l'espace 4, il s'ensuit que six composantes du moment sont conservées - trois composantes du moment cinétique tridimensionnel M je = 1/2E ijk M jk et trois soi-disant booste N je =c -

je M 0je(je, j, k= 1, 2, 3, E ijk- un seul tenseur totalement antisymétrique ; la sommation est implicite sur les indices apparaissant deux fois). Avec les mathématiques. point de vue dix fonds. quantités - R. moi, M je, N je- essence générateurs de groupe Poincaré. Si l'action reste invariante même lorsque certaines autres transformations continues sont effectuées sur le domaine considéré qui ne sont pas incluses dans le groupe de Poincaré - transformations internes. symétrie, - du théorème de Noether il découle donc l'existence de nouvelles dynamiques conservées. quantités Ainsi, ils supposent souvent que les fonctions de champ sont complexes et imposent la condition hermitienne au lagrangien (voir. Opérateur hermitien) et nécessitent l'invariance de l'action par rapport au global transformation de jauge(la phase a ne dépend pas de X) et un(X)""e je un et un(X), tu*a(X)""e -

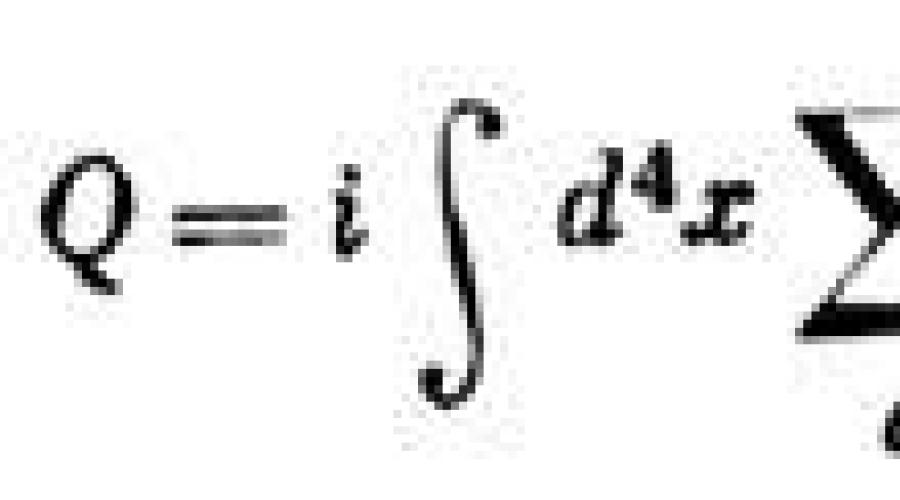

je un tu*a(X). Il s’avère alors (suite au théorème de Noether) que la charge est conservée

Par conséquent, des fonctions complexes et un peut être utilisé pour décrire la charge. des champs. Le même objectif peut être atteint en élargissant la gamme de valeurs couvertes par les indices UN, de sorte qu'ils indiquent la direction dans l'isotope. l'espace, et exigeant que l'action soit invariante par rapport aux rotations dans celui-ci. Notez que la charge Q n’est pas nécessairement électrique. charge, il peut s'agir de toute caractéristique de champ conservée non associée au groupe Poincaré, par exemple, nombre de leptons, étrangeté, nombre de baryons et ainsi de suite. Quantification canonique,selon principes généraux la mécanique quantique, est-ce que les coordonnées généralisées [c.-à-d. c'est-à-dire un ensemble (infini) de valeurs de tous les composants du champ toi 1 , . . ., u N en tous points X l'espace à un moment donné t(dans une présentation plus sophistiquée - en tous points d'une certaine hypersurface spatiale s] et impulsions généralisées p b(X, t)=dL/dub(x, t) sont déclarés comme des opérateurs agissant sur l'amplitude d'état (vecteur d'état) du système, et les relations de commutation leur sont imposées :

Par ailleurs, les signes « + » ou « - » correspondent à une quantification selon Fermi - Dirac ou Bose - Einstein (voir ci-dessous). Ici d un B - Symbole Kronecker,d( xy) - fonction delta Dirac. En raison du rôle mis en évidence du temps et de la référence inévitable à un système de référence spécifique, les relations de permutation (1) violent la symétrie explicite de l'espace et du temps, et la préservation de l'invariance relativiste nécessite des exigences particulières. preuve. De plus, les relations (1) ne disent rien sur la commutation. propriétés des champs dans des paires de points espace-temps de type temps - les valeurs des champs en ces points sont causalement dépendantes et leurs permutations ne peuvent être déterminées qu'en résolvant l'équation du mouvement avec (1). Pour les champs libres, pour lesquels les équations du mouvement sont linéaires, un tel problème est résoluble sous forme générale et permet d'établir - et, de plus, sous une forme relativistement symétrique - des relations de permutation de champs en deux points arbitraires X Et à.

Ici D t - fonction de permutation Pauli - Jordana, satisfaisante Klein - L'équation de Gordon Pab- un polynôme qui assure la satisfaction du membre droit (2) des équations du mouvement le long X et par à, - Opérateur D-Alembert, t- masse du champ quantique (ci-après le système d'unités h= Avec= 1). Dans l'approche corpusculaire de la description quantique relativiste des particules libres, les vecteurs d'état de la particule doivent former une représentation irréductible du groupe de Poincaré. Cette dernière est fixée en précisant les valeurs des opérateurs Casimir (opérateurs qui font la navette avec l'ensemble des dix groupes électrogènes du groupe). R. m M je Et N je), dont le groupe Poincaré en possède deux. Le premier est l’opérateur de masse au carré m 2 =R. m R. m. À m 2 n° 0 le deuxième opérateur de Casimir est le carré du spin ordinaire (tridimensionnel), et à masse nulle - l'opérateur d'hélicité (projection du spin sur la direction du mouvement). Gamme m 2 est continu - le carré de la masse peut avoir n'importe quel nombre non négatif. significations, m 20 ; le spectre de spin est discret, il peut avoir des valeurs entières ou semi-entières : 0, 1 / 2, 1, ... De plus, il faut préciser le comportement du vecteur d'état à la réflexion nombre impair axes de coordonnées. Si aucune autre caractéristique n’est requise, on dit que la particule n’a aucune propriété interne. degrés de liberté et ce qu'on appelle vraie particule neutre. Sinon, la particule a des charges d'une sorte ou d'une autre. Pour fixer l'état d'une particule au sein d'une représentation, en mécanique quantique il est nécessaire de spécifier les valeurs d'un ensemble complet d'opérateurs de navettage. Le choix d'un tel ensemble est ambigu ; pour une particule libre, il convient de prendre trois composantes de sa quantité de mouvement R. et la projection revient je c'est sur k--l. direction. Ainsi, l'état d'une particule libre véritablement neutre est complètement caractérisé en spécifiant les nombres t, l s, р x, p y, р z, s, dont les deux premiers déterminent la représentation, et les quatre suivants déterminent l'état qui s'y trouve. Pour charger plus de particules seront ajoutées ; Désignons-les par la lettre t. Dans la représentation des nombres d'occupation, l'état d'une collection de particules identiques est fixé remplir les nombres n p,s, t de tous les états d'une seule particule (les indices caractérisant la représentation, en général, ne sont pas écrits). À son tour, le vecteur d'état | np,s, t > s'écrit comme le résultat de l'action sur l'état de vide |0> (c'est-à-dire un état dans lequel il n'y a aucune particule) des opérateurs de création une + (p, s,t):

Opérateurs de naissance UN+ et ses opérateurs d'annihilation hermitiens conjugués UN -

satisfaire les relations de commutation

où les signes «+» et «-» correspondent respectivement à la quantification Fermi - Dirac et Bose - Einstein, et les nombres d'occupation sont les bons. valeurs des opérateurs de nombre de particules Ainsi, le vecteur d'état d'un système contenant chacune une particule avec des nombres quantiques p 1 ,

s 1, t 1 ; p 2 , s 2, t 2 ; . . ., écrit comme

Pour prendre en compte les propriétés locales de la théorie, il faut traduire les opérateurs un B dans une représentation coordonnée. Il est pratique d'utiliser les fonctions classiques comme fonctions de transformation. résoudre les équations de mouvement d'un champ libre approprié avec des indices tensoriels (ou spineurs) UN et index symétrie interne q. Alors les opérateurs de création et d'annihilation dans la représentation coordonnée seront :

Ces opérateurs sont cependant encore inadaptés à la construction d'un QFT local : leur commutateur et leur anticommutateur sont proportionnels à la fonction de Pauli-Jordan. D t, et ses parties de fréquence positives et négatives D 6 m(xy)[ré m = ré + m + ré -

m], qui pour des paires de points de type spatial X Et à ne va pas à zéro. Pour obtenir un champ local, il faut construire une superposition des opérateurs de création et d'annihilation (5). Pour les particules véritablement neutres, cela peut être fait directement en définissant le champ covariant de Lorentz local comme

tu es un(X)=tu es un(+

) (X) + et un(-) (X). (6)

Mais pour charger. les particules ne peuvent pas faire cela : opérateurs un + t et un- t dans (6) l'un augmentera et l'autre diminuera la charge, et leur combinaison linéaire n'aura pas de définition à cet égard. propriétés. Ainsi, pour former un champ local il faut s'associer avec les opérateurs de création un + t les opérateurs d'annihilation ne sont pas les mêmes particules, mais de nouvelles particules (marquées d'un tilde en haut), implémentant la même représentation du groupe de Poincaré, c'est-à-dire ayant exactement la même masse et le même spin, mais différant de celles d'origine par la charge signez (signes de toutes les charges t) et écrivez :

Depuis Les théorèmes de Pauli Il s'ensuit maintenant que pour les champs de spin entier, dont les fonctions de champ fournissent une représentation unique du groupe de Lorentz, lors de la quantification de Bose-Einstein les commutateurs [ Et(X), Et(à)]_

ou [ Et(X), v*(à)]_

proportionnel les fonctions DM(xy) et disparaissent en dehors du cône de lumière, tandis que pour ceux qui implémentent des représentations à deux valeurs de champs de spin demi-entiers, la même chose est obtenue pour les anticommutateurs [ Et(X), Et(à)] +

(ou [ v(X), v* (oui)] +) pour la quantification Fermi-Dirac. La connexion exprimée par les formules (6) ou (7) entre les fonctions de champ covariantes de Lorentz satisfaisant les équations linéaires Et ou v,v* et opérateurs de création et de destruction de particules libres en mécanique quantique stationnaire. déclare qu'il existe un calcul exact. description de la dualité onde-particule. Les nouvelles particules « nées » par les opérateurs, sans lesquelles il était impossible de construire des champs locaux (7), sont appelées - par rapport aux originales - antiparticules. L'inévitabilité de l'existence d'une antiparticule pour chaque charge. particules - l'un des ch. conclusions théorie des quanta champs libres.

3. Interactions sur le terrain Solutions (6) et (7) des équations proportionnelles en champ libre. opérateurs de création et d'annihilation de particules dans des états stationnaires, c'est-à-dire qu'ils ne peuvent décrire que de telles situations où rien n'arrive aux particules. Afin de considérer également les cas où certaines particules influencent le mouvement des autres ou se transforment en d'autres, il est nécessaire de rendre les équations du mouvement non linéaires, c'est-à-dire d'inclure dans le Lagrangien, en plus des termes quadratiques dans les champs, également des termes avec des diplômes supérieurs. Du point de vue de la théorie développée jusqu’à présent, une telle interaction Lagrangienne Peluche pourrait être n'importe quelle fonction de corps et ses dérivées premières, satisfaisant uniquement la série conditions simples: 1) localité d'interaction, exigeant que Peluche(X) dépendait de diff. des champs et un(X) et leurs dérivées premières en un seul point de l'espace-temps X; 2) invariance relativiste, pour remplir la coupe Peluche doit être un scalaire par rapport aux transformations de Lorentz ; 3) invariance sous transformations à partir de groupes de symétrie internes, si le modèle considéré en a. Pour les théories à champs complexes, cela inclut, en particulier, les exigences pour que le lagrangien soit hermitien et invariant par rapport aux transformations de jauge admissibles dans de telles théories. De plus, on peut exiger que la théorie soit invariante sous certaines transformations discrètes, telles que inversion spatiale P, inversion temporelle T Et conjugaison de charges C(en remplaçant les particules par des antiparticules). Prouvé ( Théorème CPT), que toute interaction satisfaisant aux conditions 1)-3) doit nécessairement être invariante par rapport au même temps. effectuer ces trois transformations discrètes. La variété des Lagrangiens d'interaction satisfaisant les conditions 1)-3) est aussi large que, par exemple, la variété des fonctions de Lagrange dans le classique. mécanique, et sur certains Au stade de développement de QFT, il semblait que la théorie ne répondait pas à la question de savoir pourquoi certains d'entre eux, et pas d'autres, se réalisent dans la nature. Cependant, après que l'idée est née renormalisations Divergations UV (voir section 5 ci-dessous) et sa brillante mise en œuvre dans électrodynamique quantique(QED), une classe prédominante d’interactions a émergé – celles renormalisables. Condition 4) - la renormalisabilité s'avère très restrictive, et son ajout aux conditions 1)-3) ne laisse que les interactions avec Peluche la forme de polynômes de faible degré dans les champs considérés et les champs de spins élevés sont généralement exclus de la considération. Ainsi, l'interaction dans un QFT renormalisable ne permet pas - une différence frappante par rapport au classique. et mécanique quantique - pas de fonctions arbitraires : dès qu'un ensemble spécifique de champs est choisi, l'arbitraire dans Peluche limité à un nombre fixe constantes d'interaction(constantes de couplage). Un système complet d'équations QFT avec interaction (en Représentation Heisenberg) sont les équations du mouvement obtenues à partir du lagrangien complet ( système connecté différentiel équations aux dérivées partielles avec termes non linéaires d'interaction et d'auto-action) et canoniques. relations de commutation (1). Une solution exacte à un tel problème ne peut être trouvée que dans un petit nombre de substances physiquement peu contenantes. cas (par exemple pour certains modèles en espace-temps bidimensionnel). Par contre, canon. les relations de commutation violent, comme nous l'avons déjà mentionné, une symétrie relativiste évidente, qui devient dangereuse si, au lieu d'une solution exacte, on se contente d'une solution approchée. Donc pratique la valeur de la quantification sous la forme (1) est petite. Naïb. une méthode basée sur le passage à représentation des interactions, dans lequel les champs et une(x) satisfont les équations linéaires du mouvement pour les champs libres, et toute l'influence de l'interaction et de l'auto-action est transférée à l'évolution temporelle de l'amplitude de l'état Ф, qui n'est plus constante, mais change conformément à une équation du Type Schrödinger :

et Hamiltonien interaction Indice(t) dans cette représentation dépend du temps à travers les champs et un(x), soumis à des équations libres et à des relations de permutation relativiste-covariante (2) ; Ainsi, l’utilisation explicite de termes canoniques s’avère inutile. interrupteurs (1) pour champs en interaction. Pour comparaison avec l'expérience, la théorie doit résoudre le problème de la diffusion des particules, dans la formulation on suppose que asymptotiquement, à t""- :(+ :) le système était dans un état stationnaire (atteindra un état stationnaire) Ф_ : (Ф + :), et Ф b : sont tels que les particules qu'ils contiennent n'interagissent pas en raison des grandes distances mutuelles (voir également Hypothèse adiabatique), de sorte que toute influence mutuelle des particules ne se produit qu'à des temps finis proches de t = 0 et transforme Ф_ : en Ф + : = S F_: . Opérateur S appelé matrice de diffusion(ou S-matrice); à travers les carrés de ses éléments matriciels

les probabilités de transitions à partir d'un début donné sont exprimées. état F je dans un état final F F, c'est-à-dire eff. sections transversales différentes processus. Que., S-matrix vous permet de trouver les probabilités physiques. processus sans entrer dans les détails de l’évolution temporelle décrite par l’amplitude Ф( t). Néanmoins S-la matrice est généralement construite sur la base de l'équation (8), qui permet une solution formelle sous forme compacte :

.

en utilisant l'opérateur T chronologique ordonner, organiser tous les opérateurs de terrain par ordre décroissant de temps t = x 0 (voir Travail chronologique).L’expression (10) est cependant plutôt symbolique. procédure d'enregistrement séquentielle intégration de l'équation (8) de - : à + : sur des intervalles de temps infinitésimaux ( t, t+D t), plutôt qu’une solution utilisable. Cela peut être vu au moins par le fait que pour le calcul fluide des éléments de la matrice (9), il est nécessaire de présenter la matrice de diffusion sous la forme non pas chronologique, mais produit normal, dans lequel tous les opérateurs de création sont à gauche des opérateurs de destruction. La tâche de transformer une œuvre en une autre constitue la véritable difficulté et ne peut être résolue de manière générale.

4. Théorie des perturbations Pour cette raison pour solution constructive problème, nous devons recourir à l'hypothèse que l'interaction est faible, c'est-à-dire que l'interaction lagrangienne est petite Peluche. Ensuite, vous pouvez décomposer chronologiquement. exponentielle dans l'expression (10) d'affilée théorie des perturbations, et les éléments matriciels (9) seront exprimés dans chaque ordre de la théorie des perturbations à travers des éléments matriciels non chronologiques. exposants et des exposants chronologiques simples. produits du nombre correspondant de Lagrangiens d'interaction :

(P.- théorie de l'ordre des perturbations), c'est-à-dire qu'il faudra transformer non pas des exponentielles, mais de simples polynômes sous forme normale type spécifique. Cette tâche est pratiquement accomplie grâce à la technologie Diagrammes de Feynman et Feynman a gouverné. Dans la technique de Feynman, chaque champ et une(x) est caractérisé par sa fonction causale de Green ( propagateur ou fonction de propagation), D c aa"(x-y), représenté dans les diagrammes par une ligne, et chaque interaction - par une constante de couplage et un multiplicateur matriciel du terme correspondant dans Peluche montré dans le diagramme haut. La popularité de la technique du diagramme de Feynman, outre sa facilité d'utilisation, est due à sa clarté. Les diagrammes permettent de visualiser les processus de propagation (lignes) et d'interconversion (sommets) des particules - réels au départ. et états finaux et virtuels dans les états intermédiaires (sur lignes internes). Des expressions particulièrement simples sont obtenues pour les éléments matriciels de tout processus dans ordre inférieur théorie des perturbations, qui correspondent à ce qu'on appelle des diagrammes arborescents qui n'ont pas de boucles fermées - après la transition vers la représentation impulsionnelle, il ne reste plus du tout d'intégrations. Pour la base Processus QED, de telles expressions pour les éléments matriciels ont été obtenues à l'aube de l'émergence du QFT à la fin des années 1960. 20s et s'est avéré être en accord raisonnable avec l'expérience (le niveau d'accord est de 10 - 2 - 10 - 3, c'est-à-dire de l'ordre de la constante de structure fine a). Cependant, les tentatives de calcul corrections de rayonnement(c'est-à-dire des corrections associées à la prise en compte d'approximations supérieures) à ces expressions, par exemple à Klein - Nishina - Tamm f-le (voir. Klein - Formule Nishina) pour la diffusion Compton, je suis tombé sur du spécifique. des difficultés. De telles corrections correspondent à des diagrammes avec des boucles fermées de lignes particules virtuelles, dont les impulsions ne sont pas fixées par des lois de conservation, et la correction totale est égale à la somme des contributions de toutes les impulsions possibles. Il s'est avéré que dans la plupart des cas, les intégrales sur l'impulsion des particules virtuelles qui surviennent lors de la somme de ces contributions divergent dans la région UV, c'est-à-dire que les corrections elles-mêmes s'avèrent non seulement non petites, mais infinies. Selon la relation d'incertitude, les grandes impulsions correspondent aux petites distances. On pourrait donc penser que c’est physique. Les origines des divergences résident dans l’idée de localité d’interaction. À cet égard, on peut parler d'une analogie avec énergie infinie el-magn. champs d'une charge ponctuelle en classique. électrodynamique.

5. Divergences et renormalisations Formellement, mathématiquement, l'apparition de divergences est due au fait que les propagateurs DC(x) sont des fonctions singulières (plus précisément généralisées) qui ont au voisinage du cône lumineux à X 2 ~ 0 fonctionnalités telles que les pôles et les fonctions delta X 2. Par conséquent, leurs produits apparaissant dans les éléments matriciels, qui correspondent à des boucles fermées dans les diagrammes, sont mal définis en mathématiques. points de vue. Les images de Fourier impulsionnelles de tels produits n'existent peut-être pas, mais - formellement - sont exprimées par des intégrales d'impulsions divergentes. Ainsi, par exemple, l'intégrale de Feynman

(Où R.- externe 4 impulsions, k- impulsion d'intégration), correspondant au schéma à une boucle le plus simple avec deux internes. lignes scalaires (Fig.), n'existe pas.

Il est proportionnel. Transformée de Fourier du propagateur carré DC(x) champ scalaire et diverge de manière logarithmique à la limite supérieure (c'est-à-dire dans la région UV des impulsions virtuelles | k|"":, donc, par exemple, si vous coupez l'intégrale à la limite supérieure à | k|=L, alors

Où je escroquer ( R.) est l'expression finale.

Le problème des divergences UV a été résolu (au moins du point de vue de l'obtention d'expressions finales pour les quantités les plus physiquement intéressantes) au cours de la 2ème moitié. années 40 basé sur l'idée de renormalisations (renormalisations). L'essence de cette dernière est que les effets infinis des fluctuations quantiques correspondant aux boucles fermées des diagrammes peuvent être isolés en facteurs qui ont la nature de corrections à apporter. caractéristiques originales systèmes. En conséquence, les masses et les constantes de couplage g changement dû à l’interaction, c’est-à-dire qu’ils sont renormalisés. Dans ce cas, en raison des divergences UV, les additifs renormalisants s'avèrent infiniment grands. Par conséquent, les relations de renormalisation

m 0 ""m=m 0 + D m=m 0 Zm (. . .),

g 0 ""g = g 0 +D g = g 0 Zg(. . .)

(Où Zm, Zg- facteurs de renormalisation) reliant ceux d'origine, les soi-disant. masses de graines m 0 et charges de départ (c'est-à-dire constantes de couplage) g 0 avec physique t, g, s'avèrent être singulier. Afin de ne pas avoir affaire à des expressions sans fin et dénuées de sens, l'un ou l'autre auxiliaire est introduit. régularisation des divergences(similaire au seuil utilisé dans (13) à | k|=L. Dans les arguments (indiqués à droite de (14) par des ellipses) rayonnement. amendements D m, D g, ainsi que les facteurs de renormalisation Z je, en plus T 0 et g 0, contient des dépendances singulières sur les paramètres auxiliaires. régularisation. L'élimination des divergences se produit en identifiant les masses et les charges renormalisées m Et g avec leur physique valeurs. En pratique, pour éliminer les divergences, la technique de l'introduction dans le lagrangien original est souvent utilisée : contre-membres et exprimer T 0 et g 0 dans le Lagrangien par physique m Et g relations formelles inverses à (14). Développer (14) en séries selon la physique. paramètre d'interaction :

T 0 = T + GM 1 + g 2 M 2 + ..., g 0 = g + g 2 g 1 + g 3 g 2 + ...,

sélectionner des coefficients singuliers M l, G je ainsi, afin de compenser exactement les divergences survenant dans les intégrales de Feynman. Une classe de modèles QFT pour laquelle un tel programme peut être exécuté de manière cohérente dans tous les ordres de théorie des perturbations et dans laquelle, c'est-à-dire, sans exception, toutes les divergences UV peuvent être « supprimées » dans les facteurs de renormalisation des masses et les constantes de couplage, appelées classe de théories renormalisables. Dans les théories de ce type, tous les éléments matriciels et les fonctions de Green finissent par être exprimés de manière non singulière à travers la physique. masses, charges et cinématique. variables. Dans les modèles renormalisables, on peut donc, si on le souhaite, faire complètement abstraction des simples paramètres et des divergences UV, considérés séparément, et caractériser pleinement les résultats théoriques. calculs en spécifiant un nombre fini de physiques valeurs des masses et des charges. Mathématiques. la base de cette déclaration est Bogolyubov - Théorème de Parasyuk sur la renormalisabilité. Il en résulte suffisamment recette simple obtenir des expressions finies sans ambiguïté pour les éléments matriciels, formalisées sous la forme de ce qu'on appelle. Opérations R Bogolyubova. En même temps, dans les modèles non renormalisables, dont un exemple est la formulation désormais obsolète sous la forme d'un lagrangien de Fermi local à quatre fermions, il n'est pas possible de « collecter » toutes les divergences en « agrégats » qui renormalisent les masses. et les frais. Les modèles QFT renormalisables sont caractérisés, en règle générale, par des constantes de couplage sans dimension, des contributions logarithmiquement divergentes à la renormalisation des constantes de couplage et des masses de fermions, et des rayons quadratiquement divergents. corrections des masses des particules scalaires (le cas échéant). Pour de tels modèles, suite à la procédure de renormalisation, nous obtenons théorie des perturbations renormalisées, bords et sert de base pour la pratique. calculs. Dans les modèles QFT renormalisables, un rôle important est joué par les fonctions de Green renormalisées (propagateurs habillés) et parties apicales, y compris les effets d’interaction. Ils peuvent être représentés par des sommes infinies de termes correspondant à des diagrammes de Feynman de plus en plus complexes avec un nombre et un type d'extension fixes. lignes. Pour de telles quantités, on peut donner des définitions formelles soit par milieu sous vide chronologique produits d'opérateurs de champ dans la représentation d'interaction et la matrice S (qui équivaut aux moyennes sous vide des produits T des opérateurs complets, c'est-à-dire Heisenberg), ou via des dérivées fonctionnelles de générer fonctionnel Z(J), exprimé à travers ce qu'on appelle matrice de diffusion étendue S( J.), fonctionnellement dépendant de l'auxiliaire. classique sources J une (x)des champs et un(x). Le formalisme de génération de fonctionnelles dans QFT est un analogue du formalisme correspondant de la théorie statistique. la physique. Il permet d'obtenir des équations complètes de fonctions de Green et de fonctions de sommet en dérivées fonctionnelles - Équations de Schwinger, à partir de laquelle on peut à son tour obtenir une chaîne infinie d'intégro-différentielles. niveau - -Équations de Dyson. Ces dernières s’apparentent à une chaîne d’équations de corrélations. fonctions statistiques la physique.

6. Groupe asymptotique UV et renormalisation Les divergences à haute énergie sont étroitement liées aux divergences UV dans QFT. comportement asymptotique des expressions renormalisées. Par exemple, logarithmique divergence (12) de l'intégrale de Feynman la plus simple Je(p) répond de manière logarithmique. asymptotique

intégrale régularisée finie (13), ainsi que l'expression renormalisée correspondante. Puisque dans les modèles renormalisables avec constantes de couplage sans dimension, les divergences sont principalement logarithmiques. caractère, asymptotique UV je-intégrales de boucle, en règle générale (à l'exception du cas asymptotiques deux fois logarithmiques), ont ici une structure typique ( GL)je, Où L= ln(- R. 2/m2), p est une « grande » impulsion, et m est un certain paramètre de la dimension de masse qui apparaît dans le processus de renormalisation. Par conséquent, avec suffisamment grandes valeurs |R. 2 | la croissance du logarithme compense la petitesse de la constante de couplage g et le problème se pose de déterminer un terme arbitraire de la série de la forme

et en résumant une telle série ( un film- coefficients numériques). La résolution de ces problèmes est facilitée par l'utilisation de la méthode groupe de renormalisation, qui est basé sur la nature de groupe des transformations finies similaires aux fonctions de renormalisation singulières (14) et aux transformations qui les accompagnent des fonctions de Green. De cette manière, il est possible de résumer efficacement certains ensembles infinis de contributions des diagrammes de Feynman et, en particulier, de représenter des doubles développements (15) sous la forme de simples :

où sont les fonctions f l avoir aspect caractéristique géom. progression ou une combinaison d'une progression avec son logarithme et son exposant. Ce qui est très important ici, c'est la condition d'applicabilité type f-l(15), ayant la forme g<<1, GL<<

1, est remplacé par un beaucoup plus faible : - soi-disant. charge invariante, qui dans l'approximation la plus simple (une boucle) a la forme d'une somme de geoms. progression par argument GL :

![]() (b 1 - coefficient numérique). Par exemple, en QED, la charge invariante est proportionnelle à la partie transversale du propagateur de photons. d, dans l'approximation à une boucle s'avère égal

(b 1 - coefficient numérique). Par exemple, en QED, la charge invariante est proportionnelle à la partie transversale du propagateur de photons. d, dans l'approximation à une boucle s'avère égal

et avec k 2 /m 2 >0 L=ln( k 2 /m 2)+ je p( k- 4 impulsions d'un photon virtuel). C'est une expression représentant la somme de ch. logarithmes de la forme a(a L)n, a ce qu'on appelle poteau fantôme à k 2 = -m 2 e 3 p/a, ainsi appelé car sa position et surtout le signe du résidu contredisent un certain nombre de propriétés générales de QFT (exprimées, par exemple, représentation spectrale pour propagateur de photons). La présence de ce pôle est étroitement liée au problème de ce qu'on appelle. zéro frais,T. c'est-à-dire que la charge renormalisée devient nulle à une valeur finie de la charge « graine ». La difficulté liée à l’apparition du poteau fantôme a même parfois été interprétée comme une preuve d’interne. incohérences du QED, et le transfert de ce résultat au traditionnel. modèles renormalisables de forte interaction des hadrons - comme indication de l'incohérence de l'ensemble du QFT local dans son ensemble. Cependant, ces conclusions cardinales sont tirées du chapitre. logarithmique les approches se sont révélées précipitées. En prenant déjà en compte les contributions « suivantes les principales » ~a 2 (a L)m, conduisant à l'approximation à deux boucles, montre que la position du pôle se déplace sensiblement. Une analyse plus générale dans le cadre de la méthode de renormalisation. groupe conduit à la conclusion que la formule (16) n'est applicable que dans la région ![]() c’est-à-dire l’impossibilité de prouver ou de réfuter l’existence d’une « contradiction polaire » sur la base de l’une ou l’autre récapitulation de séries (15). Ainsi, le paradoxe du phénomène d'un pôle fantomatique (ou du renversement d'une charge renormalisée à zéro) s'avère illusoire - il ne serait possible de décider si cette difficulté apparaît réellement en théorie que si l'on pouvait obtenir des résultats sans ambiguïté Jusque-là Pour l'instant, la seule conclusion qui reste est que - lorsqu'elle est appliquée au spinor QED - la théorie des perturbations n'est pas, malgré la petitesse inconditionnelle du paramètre d'expansion a, une théorie logiquement fermée. Pour le QED, cependant, ce problème pourrait être considéré comme purement académique, puisque, selon (16), même aux énergies gigantesques ~(10 15 -10 16) GeV, considérées à l'époque moderne. modèles d'interactions combinées, la condition n'est pas violée. La situation en mésodynamique quantique - la théorie de l'interaction des champs de mésons pseudoscalaires avec les champs de fermions des nucléons, présentée au début - semblait beaucoup plus grave. années 60 unité candidat pour le rôle d’un modèle renormalisable d’interaction forte. Dans ce document, la constante de couplage effective était élevée aux énergies ordinaires, et la prise en compte - clairement non autorisée - de la théorie des perturbations conduisait aux mêmes difficultés que celles de la charge nulle. À la suite de toutes les études décrites, une vision quelque peu pessimiste s’est dégagée. point de vue sur les perspectives futures du QFT renormalisable. Purement théorique. d'un point de vue il me semblait que les qualités. la variété de ces théories est négligeable : pour tout modèle renormalisable, tous les effets d'interaction - pour de petites constantes de couplage et des énergies modérées - se limitaient à un changement inobservable dans les caractéristiques des particules libres et au fait que des transitions quantiques se produisaient entre les états avec de telles particules, aux probabilités de l'approximation la plus basse dont il était désormais possible de calculer de (petites) corrections des plus élevées. Pour les grandes constantes de couplage ou les énergies asymptotiquement grandes, la théorie existante – encore une fois quel que soit le modèle spécifique – était inapplicable. La seule application (certes brillante) au monde réel qui satisfaisait à ces restrictions était QED. Cette situation a contribué au développement de méthodes non hamiltoniennes (telles que théorie axiomatique des champs quantiques, approche algébrique en KTP, théorie quantique constructive des champs). De grands espoirs étaient placés sur méthode des relations de dispersion et recherche analytique. propriétés de la matrice S. Mn. les chercheurs ont commencé à chercher une issue aux difficultés en révisant les principes de base. dispositions de QFT renormalisé local avec l'aide du développement de non canoniques. directions : essentiellement non linéaires (c'est-à-dire non polynomiales), non locales, non définies (voir. Théories quantiques des champs non polynomiaux, Théorie des champs quantiques non locaux, Métrique indéfinie) etc. La source de nouvelles vues sur la situation générale du QFT a été la découverte de nouvelles théories théoriques. faits liés aux non-abéliens champs de jauge.

7. Champs d'étalonnage Champs de jauge (y compris non abéliens Champ Young-Mills) sont associés à l'invariance par rapport à un groupe g transformations de jauge locales. L’exemple le plus simple d’un champ de jauge est un aimant électrique. champ UN m en QED associé au groupe abélien U(l). Dans le cas général d'une symétrie ininterrompue, les champs de Yang-Mills, comme un photon, ont une masse au repos nulle. Ils sont convertis par la représentation de groupe ci-jointe g, portent les indices correspondants Bab m( X) et obéissent à des équations de mouvement non linéaires (linéarisables uniquement pour le groupe abélien). Leur interaction avec les champs de matière sera invariante de jauge si elle est obtenue en étendant les dérivées (voir. Dérivée covariante):

dans le lagrangien libre du champ et avec la même constante sans dimension g, qui est inclus dans le Lagrangien du champ DANS. Comme El-Magn. champ, les champs Yang-Mills sont des systèmes avec des connexions. Ceci, ainsi que l'absence apparente de particules vectorielles sans masse (autres que les photons) dans la nature, ont limité l'intérêt pour de tels domaines et, pendant plus de 10 ans, ils ont été considérés davantage comme un modèle élégant sans rapport avec le monde réel. La situation a changé au 2ème étage. années 60, lorsqu'ils ont pu être quantifiés grâce à la méthode d'intégration fonctionnelle (voir. Méthode intégrale fonctionnelle) et découvrez que le champ de Yang-Mills pur sans masse et le champ interagissant avec les fermions sont renormalisables. Suite à cela, une méthode a été proposée pour introduire « en douceur » des masses dans ces champs en utilisant l'effet rupture spontanée de symétrie. Basé sur cela Mécanisme de Higgs permet de conférer une masse aux quanta des champs de Yang-Mills sans violer la renormalisabilité du modèle. Sur cette base, en con. années 60 une théorie unifiée renormalisable du faible et de l'el-magnétique a été construite. interactions (voir Interaction électrofaible), dans lequel les porteurs d'interaction faible sont des quanta lourds (avec des masses ~ 80-90 GeV) de champs de jauge vectorielle du groupe de symétrie électrofaible ( Bosons vecteurs intermédiaires W 6 et Z 0, observé expérimentalement en 1983). Enfin, au début. années 70 a été découvert avis. propriété des QFT non abéliens - liberté asymptotique Il s'est avéré que, contrairement à tous les QFT renormalisables étudiés jusqu'à présent, le champ de Yang-Mills est à la fois pur et interagissant avec des restrictions. nombre de fermions, ch. logarithmique les contributions à la charge invariante ont un signe total opposé au signe de ces contributions au QED :

c’est-à-dire l’impossibilité de prouver ou de réfuter l’existence d’une « contradiction polaire » sur la base de l’une ou l’autre récapitulation de séries (15). Ainsi, le paradoxe du phénomène d'un pôle fantomatique (ou du renversement d'une charge renormalisée à zéro) s'avère illusoire - il ne serait possible de décider si cette difficulté apparaît réellement en théorie que si l'on pouvait obtenir des résultats sans ambiguïté Jusque-là Pour l'instant, la seule conclusion qui reste est que - lorsqu'elle est appliquée au spinor QED - la théorie des perturbations n'est pas, malgré la petitesse inconditionnelle du paramètre d'expansion a, une théorie logiquement fermée. Pour le QED, cependant, ce problème pourrait être considéré comme purement académique, puisque, selon (16), même aux énergies gigantesques ~(10 15 -10 16) GeV, considérées à l'époque moderne. modèles d'interactions combinées, la condition n'est pas violée. La situation en mésodynamique quantique - la théorie de l'interaction des champs de mésons pseudoscalaires avec les champs de fermions des nucléons, présentée au début - semblait beaucoup plus grave. années 60 unité candidat pour le rôle d’un modèle renormalisable d’interaction forte. Dans ce document, la constante de couplage effective était élevée aux énergies ordinaires, et la prise en compte - clairement non autorisée - de la théorie des perturbations conduisait aux mêmes difficultés que celles de la charge nulle. À la suite de toutes les études décrites, une vision quelque peu pessimiste s’est dégagée. point de vue sur les perspectives futures du QFT renormalisable. Purement théorique. d'un point de vue il me semblait que les qualités. la variété de ces théories est négligeable : pour tout modèle renormalisable, tous les effets d'interaction - pour de petites constantes de couplage et des énergies modérées - se limitaient à un changement inobservable dans les caractéristiques des particules libres et au fait que des transitions quantiques se produisaient entre les états avec de telles particules, aux probabilités de l'approximation la plus basse dont il était désormais possible de calculer de (petites) corrections des plus élevées. Pour les grandes constantes de couplage ou les énergies asymptotiquement grandes, la théorie existante – encore une fois quel que soit le modèle spécifique – était inapplicable. La seule application (certes brillante) au monde réel qui satisfaisait à ces restrictions était QED. Cette situation a contribué au développement de méthodes non hamiltoniennes (telles que théorie axiomatique des champs quantiques, approche algébrique en KTP, théorie quantique constructive des champs). De grands espoirs étaient placés sur méthode des relations de dispersion et recherche analytique. propriétés de la matrice S. Mn. les chercheurs ont commencé à chercher une issue aux difficultés en révisant les principes de base. dispositions de QFT renormalisé local avec l'aide du développement de non canoniques. directions : essentiellement non linéaires (c'est-à-dire non polynomiales), non locales, non définies (voir. Théories quantiques des champs non polynomiaux, Théorie des champs quantiques non locaux, Métrique indéfinie) etc. La source de nouvelles vues sur la situation générale du QFT a été la découverte de nouvelles théories théoriques. faits liés aux non-abéliens champs de jauge.

7. Champs d'étalonnage Champs de jauge (y compris non abéliens Champ Young-Mills) sont associés à l'invariance par rapport à un groupe g transformations de jauge locales. L’exemple le plus simple d’un champ de jauge est un aimant électrique. champ UN m en QED associé au groupe abélien U(l). Dans le cas général d'une symétrie ininterrompue, les champs de Yang-Mills, comme un photon, ont une masse au repos nulle. Ils sont convertis par la représentation de groupe ci-jointe g, portent les indices correspondants Bab m( X) et obéissent à des équations de mouvement non linéaires (linéarisables uniquement pour le groupe abélien). Leur interaction avec les champs de matière sera invariante de jauge si elle est obtenue en étendant les dérivées (voir. Dérivée covariante):

dans le lagrangien libre du champ et avec la même constante sans dimension g, qui est inclus dans le Lagrangien du champ DANS. Comme El-Magn. champ, les champs Yang-Mills sont des systèmes avec des connexions. Ceci, ainsi que l'absence apparente de particules vectorielles sans masse (autres que les photons) dans la nature, ont limité l'intérêt pour de tels domaines et, pendant plus de 10 ans, ils ont été considérés davantage comme un modèle élégant sans rapport avec le monde réel. La situation a changé au 2ème étage. années 60, lorsqu'ils ont pu être quantifiés grâce à la méthode d'intégration fonctionnelle (voir. Méthode intégrale fonctionnelle) et découvrez que le champ de Yang-Mills pur sans masse et le champ interagissant avec les fermions sont renormalisables. Suite à cela, une méthode a été proposée pour introduire « en douceur » des masses dans ces champs en utilisant l'effet rupture spontanée de symétrie. Basé sur cela Mécanisme de Higgs permet de conférer une masse aux quanta des champs de Yang-Mills sans violer la renormalisabilité du modèle. Sur cette base, en con. années 60 une théorie unifiée renormalisable du faible et de l'el-magnétique a été construite. interactions (voir Interaction électrofaible), dans lequel les porteurs d'interaction faible sont des quanta lourds (avec des masses ~ 80-90 GeV) de champs de jauge vectorielle du groupe de symétrie électrofaible ( Bosons vecteurs intermédiaires W 6 et Z 0, observé expérimentalement en 1983). Enfin, au début. années 70 a été découvert avis. propriété des QFT non abéliens - liberté asymptotique Il s'est avéré que, contrairement à tous les QFT renormalisables étudiés jusqu'à présent, le champ de Yang-Mills est à la fois pur et interagissant avec des restrictions. nombre de fermions, ch. logarithmique les contributions à la charge invariante ont un signe total opposé au signe de ces contributions au QED :

Par conséquent, à la limite | k 2 |" : charge invariante et aucune difficulté ne survient lors du passage à la limite UV. Ce phénomène d'auto-extinction de l'interaction à petites distances (liberté asymptotique) a permis d'expliquer naturellement dans la théorie de jauge de l'interaction forte - chromodynamique quantique(QCD) structure partonique des hadrons (voir. Les Partons), qui s'était manifesté à cette époque dans des expériences sur la diffusion profondément inélastique des électrons sur les nucléons (voir. Des processus profondément inélastiques). La base symétrique de QCD est le groupe S.U.(3) c, agissant dans l'espace dit. variables de couleur. Des nombres quantiques de couleurs non nuls sont attribués à quarks Et gluons. La spécificité des états de couleur est leur inobservabilité à des distances spatiales asymptotiquement grandes. Dans le même temps, les baryons et les mésons qui apparaissent clairement expérimentalement sont des singulets du groupe des couleurs, c'est-à-dire que leurs vecteurs d'état ne changent pas lors des transformations dans l'espace colorimétrique. En inversant le signe b [cf. (17) avec (16)] la difficulté du pôle fantôme passe des hautes énergies aux petites. On ne sait pas encore ce que donne la QCD pour les énergies ordinaires (de l'ordre des masses de hadrons), il existe une hypothèse selon laquelle avec une distance croissante (c'est-à-dire avec une énergie décroissante), l'interaction entre les particules colorées augmente si fortement qu'elle est précisément ce qui ne permet pas aux quarks et gluons de se disperser à une distance de /10 - 13 cm (hypothèse de non-vol, ou confinement ; voir Rétention de la couleur Une grande attention est accordée à l'étude de ce problème. Ainsi, l’étude des modèles quantiques de champs contenant des champs de Yang-Mills a révélé que les théories renormalisables peuvent avoir une richesse de contenu inattendue. En particulier, la croyance naïve selon laquelle le spectre d'un système en interaction est qualitativement similaire au spectre d'un système libre et n'en diffère que par un déplacement de niveaux et, éventuellement, l'apparition d'un petit nombre d'états liés. Il s'est avéré que le spectre d'un système en interaction (hadrons) peut n'avoir rien de commun avec le spectre des particules libres (quarks et gluons) et peut donc même ne pas en donner une indication. domaines dans lesquels les variétés doivent être incluses dans le microscope élémentaire. Lagrangien. Établir ces qualités essentielles. fonctionnalités et détenant la grande majorité des quantités. Les calculs QCD sont basés sur une combinaison de calculs de théorie des perturbations avec l'exigence d'invariance du groupe de renormalisation. En d’autres termes, la méthode des groupes de renormalisation est devenue, avec la théorie des perturbations renormalisées, l’un des principaux outils informatiques modernes. KTP. Dr. Méthode QFT, moyens reçus. Le développement depuis les années 70, notamment dans la théorie des champs de jauge non-abéliens, est, comme déjà noté, une méthode qui utilise la méthode intégrale fonctionnelle et constitue une généralisation à la mécanique quantique QFT. méthode intégrale de chemin. Dans QFT, ces intégrales peuvent être considérées comme des formules de moyenne des formules classiques correspondantes. expressions (par exemple, la fonction de Green classique pour une particule se déplaçant dans un champ externe donné) basées sur des fluctuations quantiques de champs. Initialement, l'idée de transférer la méthode intégrale fonctionnelle vers QFT était associée à l'espoir d'obtenir des expressions fermées compactes pour les fondamentaux. quantités de champ quantique adaptées aux calculs constructifs. Cependant, il s'est avéré qu'en raison de difficultés, les calculs ont été difficiles. nature, une définition stricte ne peut être donnée que pour les intégrales de type gaussien, qui seules peuvent être calculées avec précision. Par conséquent, la représentation intégrale fonctionnelle a longtemps été considérée comme une représentation formelle compacte de la théorie quantique des perturbations de champ. Plus tard (pour détourner l’attention du problème mathématique de la justification), ils ont commencé à utiliser cette représentation de diverses manières. tâches générales. Ainsi, la représentation de l'intégrale fonctionnelle a joué un rôle important dans les travaux sur la quantification des champs de Yang-Mills et la preuve de leur renormalisabilité. Des résultats intéressants ont été obtenus en utilisant la procédure de calcul de l'intégrale fonctionnelle du fonctionnel méthode de réussite, similaire à la méthode du point selle dans la théorie des fonctions d'une variable complexe. Pour un certain nombre de modèles assez simples, cette méthode a permis de constater que les grandeurs de champ quantique considérées comme des fonctions constantes de couplage g, je suis proche du point g=0 élément de type caractéristique exp(- 1 /g) et que (en pleine conformité avec cela) les coefficients fn extensions de puissance S f n g n les théories des perturbations se multiplient P. factorielle : fn~n!. Ainsi, ce qui avait été dit au début a été confirmé de manière constructive. années 50 hypothèse sur la non-analyticité de la théorie des charges. L'analyse joue un rôle important dans cette méthode. solutions au classique non linéaire niveaux ayant un caractère localisé ( solitons et - dans la version euclidienne - instantons) et des actions qui fournissent un minimum de fonctionnalités. En 2ème mi-temps. années 70 dans le cadre de la méthode d'intégration fonctionnelle, une direction de recherche est apparue sur les champs de jauge non abéliens en utilisant ce qu'on appelle. contour, en k-poii comme arguments au lieu de points à quatre dimensions X les contours fermés Г dans l'espace-temps sont considérés. De cette manière, il est possible de réduire d'une unité la dimension de l'ensemble des variables indépendantes et, dans un certain nombre de cas, de simplifier considérablement la formulation du problème du champ quantique (voir. Approche contour). Des études réussies ont été réalisées à l'aide de calculs numériques sur ordinateur d'intégrales fonctionnelles, représentées approximativement sous la forme d'intégrales répétées de grande multiplicité. Pour une telle représentation, un réseau discret est introduit dans l’espace original des variables de configuration ou de quantité de mouvement. Semblables, comme on les appelle, aux « calculs de réseau » pour le réalisme. les modèles nécessitent l’utilisation d’ordinateurs particulièrement puissants, c’est pourquoi ils commencent tout juste à être disponibles. Ici, en particulier, un calcul encourageant des masses et des champs magnétiques anormaux a été réalisé à l'aide de la méthode de Monte Carlo. moments de hadrons basés sur la chromodynamique quantique. représentations (voir Méthode en treillis).